Область техники, к которой относится изобретение

Изобретение относится к моделированию нейронов в качестве элемента нейронных сетей, к нейрокибернетике и может найти применение при разработке нейрокомпьютеров, технических систем на основе нейронных сетей, для распознания образов, анализа и обработки изображений и многих других приложений. Целью изобретения является расширение области применения нейронных сетей, основным элементом которых является нейрон, нейросетевых технологий, создания искусственного интеллекта. Области применения предлагаемого изобретения: робототехника, нейроморфные нейрочипы, общение на основе нейротехнологий, медицинские протезы органов и мозга.

Известный уровень техники

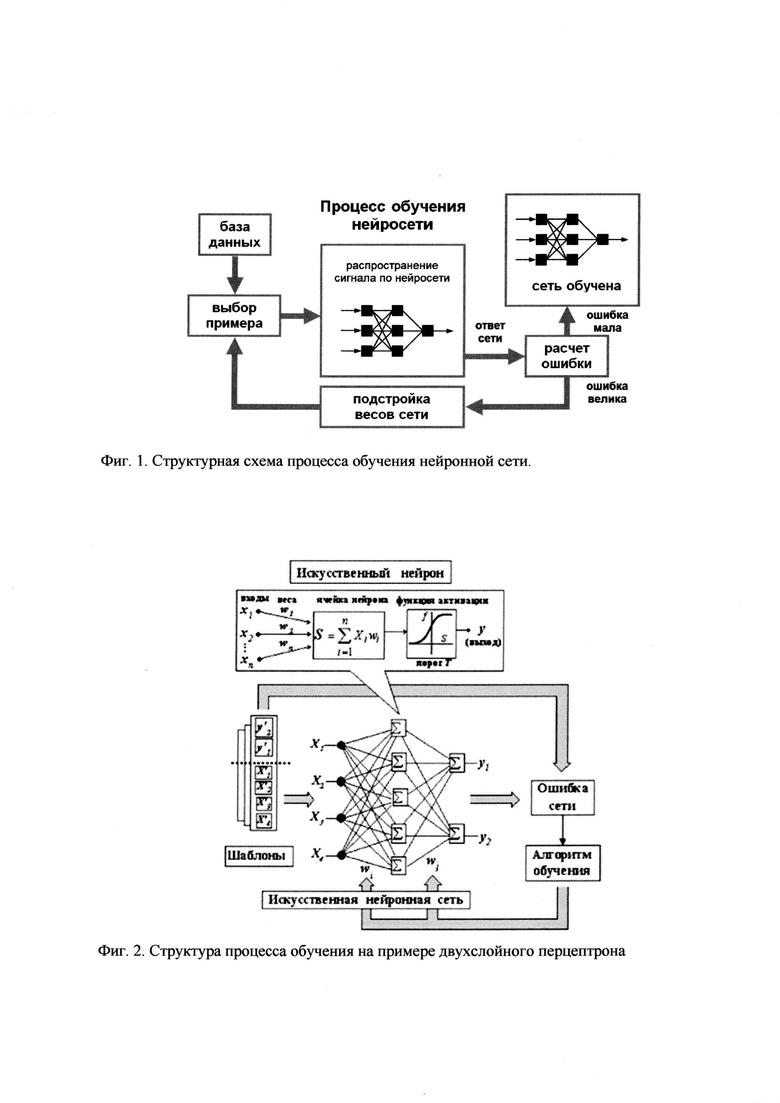

Для того, чтобы нейронная сети была способна выполнить поставленную задачу, ее необходимо обучить. Обучение наиболее распространенных нейронных сетей, использующих нейроны МакКаллока-Питтса, сводится к расчету его весовых коэффициентов [1-11]. Различают алгоритмы обучения с учителем и без учителя. Процесс обучения с учителем представляет собой предъявление сети выборки обучающих примеров. Каждый пример подается на входы сети, затем проходит обработку внутри структуры нейронной сети, вычисляется выходной сигнал сети, который сравнивается с соответствующим значением целевого вектора, представляющего требуемый выход сети. Затем по определенному правилу вычисляется ошибка, и происходит изменение весовых коэффициентов связей внутри сети в зависимости от выбранного алгоритма. Векторы обучающего множества предъявляются последовательно до тех пор, пока ошибка по всему обучающему массиву не достигнет приемлемо низкого уровня. Структурная схема процесса обучения нейронной сети показана на фиг. 1.

Фиг. 1. Структурная схема процесса обучения нейронной сети.

Более детально структурная схема процесса обучения нейронной сети иллюстрируется фиг. 2.

Фиг. 2. Структура процесса обучения на примере двухслойного перцептрона

Основной задачей учителя является выбор вида ошибки обучения, оценка величины этой ошибки, выбор изменяемых переменных, выбор величины изменения изменяемых переменных, замена одного эталонного входного сигнала из базы данных на другой входной сигнал. Наконец, в обязанности учителя входит оценка величины ошибки на основе некоторых критериев, зачастую плохо формализованных. Как видно из этого перечисления роли учителя, эта роль достаточно велика и не достаточно формализована.

При обучении с учителем методом обратного распространения ошибки роль учителя аналогична, описанной выше, с той лишь разницей, что сигнал с выхода нейронной сети попадает на вход автоматически, и все остальные действия учителя реализуются на входе. Однако, за последние 100 лет исследования нейронных сетей не обнаружено обратного распространения возбуждения с выхода нейронной сети на вход, возбуждение от входа распространяется к выходу только напрямую. К тому же при использовании метода обратного распространения ошибки требуется, чтобы пороговая функция была дважды дифференцирована, что в реальных биологических системах не имеет места, это явно надумано инженерами специалистами.

При обучении без учителя обучающее множество состоит лишь из входных векторов. Обучающий алгоритм подстраивает веса сети так, чтобы получались согласованные выходные векторы, т.е. чтобы предъявление достаточно близких входных векторов давало одинаковые выходы.

Обучению нейронных сетей посвящен ряд патентов [12-15]. В известных патентах по обучению предлагаются некоторые улучшения известного метода обучения нейронных сетей, основанного на подборе подходящих весовых коэффициентов. Как известно, эти методы имеют ряд принципиальных неустранимых недостатков, перечислим некоторые из них:

1. Основной недостаток - многозначность наборов весовых коэффициентов, удовлетворяющих неравенствам, из которых они определяются [2-11];

2. Техническая сложность итерационных процедур, связанная с большим объемом вычислений [2-11];

3. Неустойчивость, возможность появления неоднозначных решений задач распознавания и управления для некоторых наборов весовых коэффициентов [2-11].

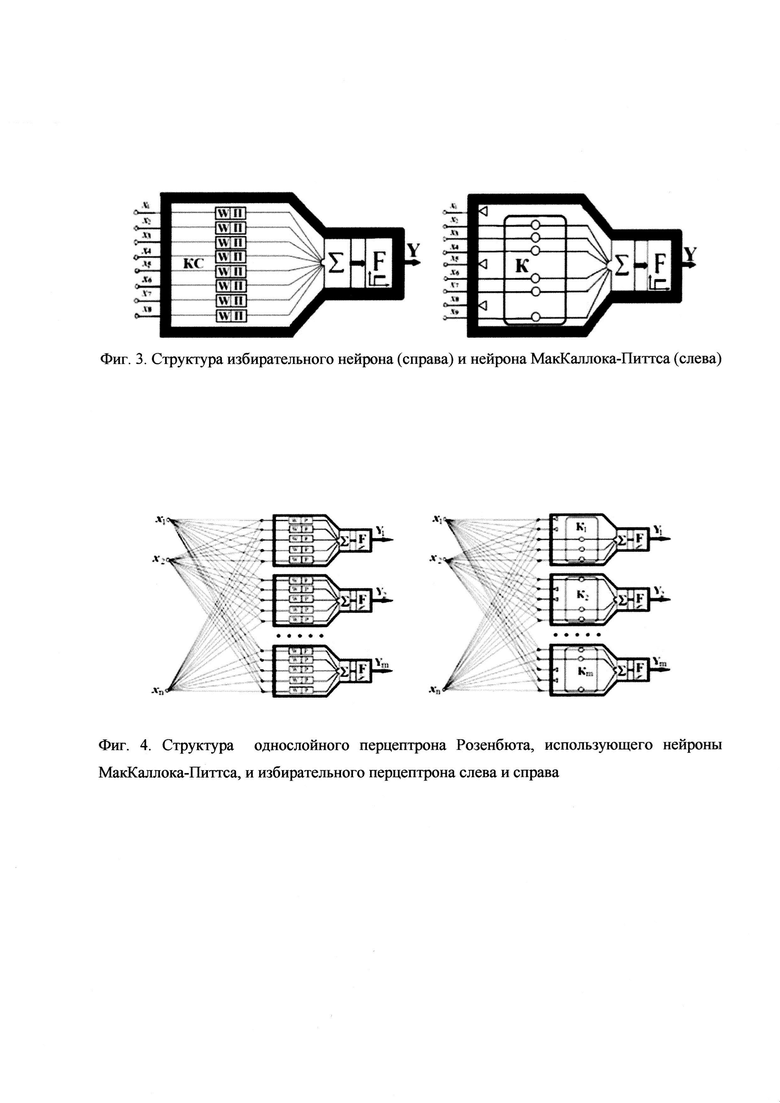

От многих недостатков нейронных сетей, основанных на обучении путем подбора весовых коэффициентов, свободны избирательные нейронные сети, использующие избирательные нейроны, описанные в работах [16-22]. В данной работе рассматривается обучение избирательных нейронных сетей с избирательными нейронами, описанными в работах [16-22]. Структура нейрона МакКаллока-Питтса и избирательного нейрона показана на фиг. 3 соответственно слева и справа.

Фиг. 3. Структура избирательного нейрона (справа) и нейрона МакКаллока-Питтса (слева)

Эффективный способ получения избирательности в перцептроне - системе из n нейронов был реализован в избирательном перцептроне, составленном из избирательных нейронов. В каждом нейроне создаются кластеры специализированных каналов связи, настроенные на соответствующие характеристические кодовые комбинации входных сигналов. Структура однослойного перцептрона Розенблюта, использующего нейроны МакКаллока-Питтса, и избирательного перцептрона показаны на фиг. 4 слева и справа

Фиг. 4. Структура однослойного перцептрона Розенблюта, использующего нейроны МакКаллока-Питтса, и избирательного перцептрона показаны на фиг. 4 слева и справа

Здесь К - сформированные кластеры каналов связи; Σ - сумматор, F - пороговые нелинейные элементы. Треугольниками отмечены заблокированные каналы связи из числа входных, не являющихся существенными для объектов на входе перцептрона. Эффективность избирательного перцептрона для случая распознавания контурных объектов следует из теоремы, приведенной в работе [18-22]. Принципиальное отличие стандартных нейронных сетей от избирательных нейронных сетей, предложенных в работах [16-22], в том, что обучение стандартных нейронных сетей производится за счет подбора весовых коэффициентов, а обучение избирательных нейронных сетей производится за счет избирательной кластеризации каналов связи.

Раскрытие сущности изобретения

Одним из способов обучения избирательной нейронной сети является инструментальный метод реализации избирательных кластеров. Дадим описание инструментального метода.

Соединим каждый регистрирующий нейрон с кодовыми комбинациями распознаваемых букв и цифр. Кодовой комбинацией называем последовательность единиц 1 и нулей 0 бинарного входного сигнала. Сначала соединяют первый нейрон с кодовыми комбинациями первой буквы или цифры, затем второй с кодовыми комбинациями второй буквы или цифры и так далее до конца последнего регистрирующего нейрона. Получаем сеть из кластеров - каналов связи каждого регистрирующего нейрона.

Другой вариант реализации инструментального метода состоит в соединении входов соответствующих существенным кодовым элементам с регистрирующим нейроном, который должен идентифицировать объект, соответствующей данной кодовой комбинации. Инструментальный процесс длится до тех пор, пока все виды, соответствующие существенным кодовым комбинациям, которые в свою очередь определяют набор распознаваемых входных объектов, не будут соединены с соответствующими регистрирующими нейронами.

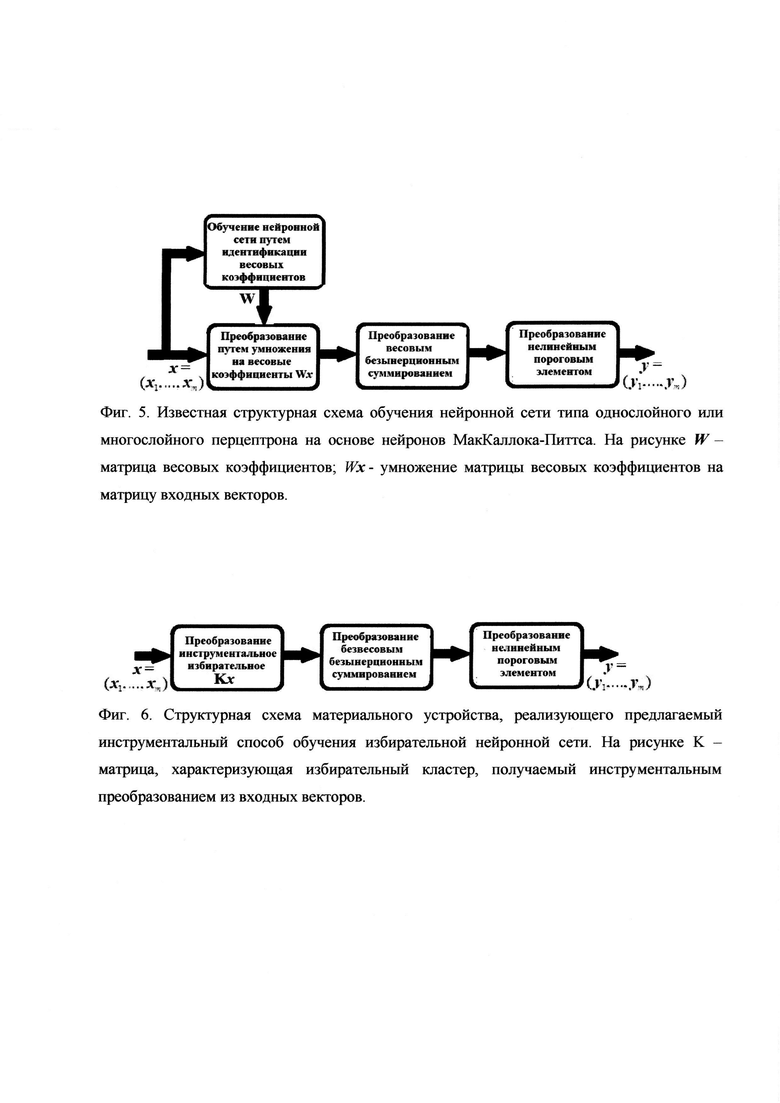

Материальное устройство, реализующее известный метод обучения нейронной сети типа однослойного или многослойного перцептрона на основе нейронов МакКаллока-Питтса, в виде структурной схемы, соответствующей схемам, показанным на фиг. 1 и фиг. 2, представленао на фиг. 5.

Фиг. 5. Известная структурная схема обучения нейронной сети типа однослойного или многослойного перцептрона на основе нейронов МакКаллока-Питтса. На рисунке W - матрица весовых коэффициентов; Wx - умножение матрицы весовых коэффициентов на матрицу входных векторов

Материальное устройство, реализующее инструментальный способ обучения избирательной нейронной сети, в виде структурной схемы показано на фиг. 6.

Фиг. 6. Структурная схема материального устройства, реализующего предлагаемый инструментальный способ обучения избирательной нейронной сети. На рисунке K - матрица, характеризующая избирательный кластер, получаемый инструментальным преобразованием из входных векторов.

На фиг. 6 под инструментальным преобразованием подразумевается любое материальное преобразование входных каналов связи нейрона. Это, например, может быть: 1. Присоединение или разъединение электрических проводников, моделирующих каналы связи нейрона; 2. Разрыв или соединение электрических проводников, моделирующих каналы связи нейрона, с помощью коммутаторов; 3. При двумерном графическом моделировании избирательной нейронной сети - графическое соединение регистрирующих нейронов с информативными элементами кодовых комбинаций на входе или наоборот соединение информативных элементов кодовых комбинаций с соответствующими регистрирующими нейронами. Примеры реализации инструментального распознавания путем инструментального создания избирательных кластеров будут приведены ниже в разделе осуществление изобретения.

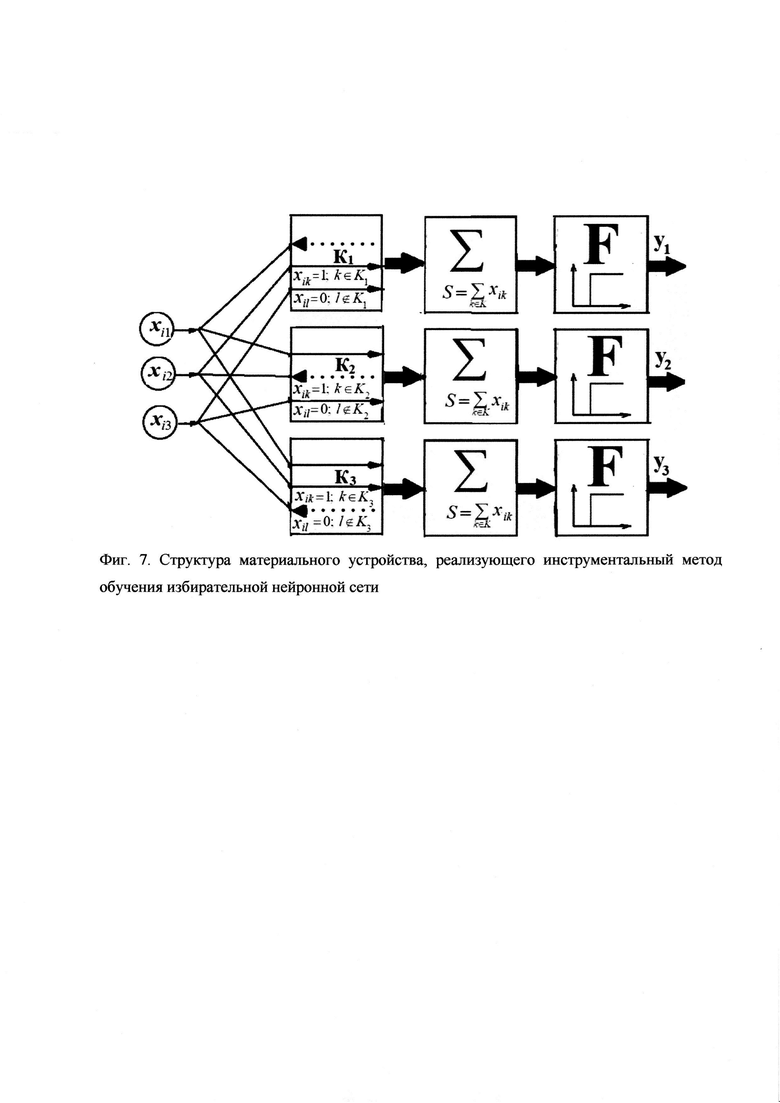

Более подробно структура материального устройства, реализующего инструментальный метод обучения избирательной нейронной сети на примере 3-х избирательных нейронов и входных сигналов xi=(xi1, xi2, xi3) (i=1, …, m), характеризуемых бинарными последовательностями из 3-х ячеек, показана на фиг. 7.

Фиг. 7. Структура материального устройства, реализующего инструментальный метод обучения избирательной нейронной сети.

На фиг. 7 для наглядности моделируется распознавание 3-х векторных объектов: xi=(xi1, xi2, xi3) (i=1, …, m). Избирательная кластеризация иллюстрируется тремя первыми по вертикали блоками на структурной схеме. Блокирование каналов и образование кластеров производится с помощью черных треугольников. Суммирование элементов векторов xi=(xi1, xi2, xi3) (i=1, …, m) производится в блоках суммирования. Затем производится нелинейное пороговое преобразование в блоках, обозначенных F.

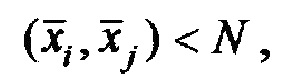

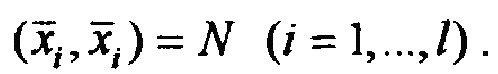

Для обоснования единственности распознавания контурных изображений избирательной нейронной сетью было реализовано пиксельное сканирование нормированных контурных объектов, сопоставляя каждому объекту бинарную строку из 0 и 1 (0 - отсутствие контура, 1 - точка контура). Тогда для несовпадающих контурных объектов  где

где  Полагаем, что линейным преобразованием нельзя совместить контурные объекты

Полагаем, что линейным преобразованием нельзя совместить контурные объекты  что позволяет реализовать линейную независимость бинарных кодов этих объектов. Доказана теорема о единственности распознавания несовместимых контурных объектов [18-20].

что позволяет реализовать линейную независимость бинарных кодов этих объектов. Доказана теорема о единственности распознавания несовместимых контурных объектов [18-20].

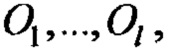

Теорема: Пусть в двумерной области, разделенной на пиксели прямоугольной решеткой, заданы m контурных объектов, несовместимых при движениях - сдвиг, прямоугольный перенос, поворот. Пусть объекты сканируются с помощью строчной развертки в бинарные последовательности - векторы из 0 и 1 длиной n, то есть xi=(xi1, …, xin) i=(1, …, m). Пусть все возможные кодовые комбинации входных сигналов собраны в матрицу А

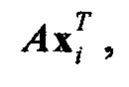

Пусть на конкретный нейрон перцептрона подается сигнал, характеризуемый кодовой комбинацией xi=(xi1, …, xin). Ответ перцептрона можно представить в виде

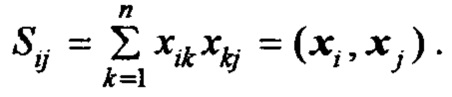

где  - транспонированный вектор-столбец из вектор-строки xi. Рассмотрим суммы

- транспонированный вектор-столбец из вектор-строки xi. Рассмотрим суммы

Представим все возможные суммы Sij (i=1, …, m; j=1, …, m), число которых равно m2, в виде матрицы В,

В=ААТ,

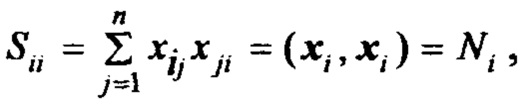

где AT - транспонированная матрица к А. Рассмотрим суммы Sii

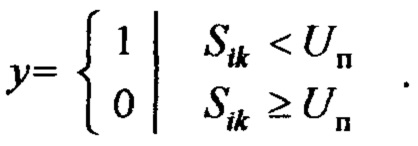

где Ni - число единиц в кодовой комбинации xi=(xi1, …, xin). Выберем пороговое значение Uп=αNi, где 0<α<1. Воспользуемся для распознавания входных объектов свойством

Тогда распознавание каждого из m входных объектов избирательным однослойным перцептроном будет единственным.

Достигаемые технические результаты

1. Решение задач распознавания, управления и других при использовании инструментального метода в избирательных нейронных сетях является при выполнении определенных условий однозначным, в то время как распознавание в нейронных сетях с нейронами МакКаллока-Питтса является многозначным, точнее бесконечно значным. Однозначность инструментального распознавания при достаточно не жестких условиях следует из приведенной ниже теоремы.

2. Значительно упрощается процедура обучения избирательных нейронных сетей, она становится доступной неспециалисту.

3. Значительно сокращается время обучения.

4. Обучение может достигаться инструментальными средствами без использования вычислительных средств.

5. Реализуется сеть устойчивая к посторонним внешним воздействиям.

6. Реализуется сеть устойчивая к неоднозначным распознаваниям, обусловленным близостью к пороговому значению некоторых недиагональных членов матрицы А⋅АТ, где AT - матрица, транспонированная к матрице А.

Осуществление изобретения

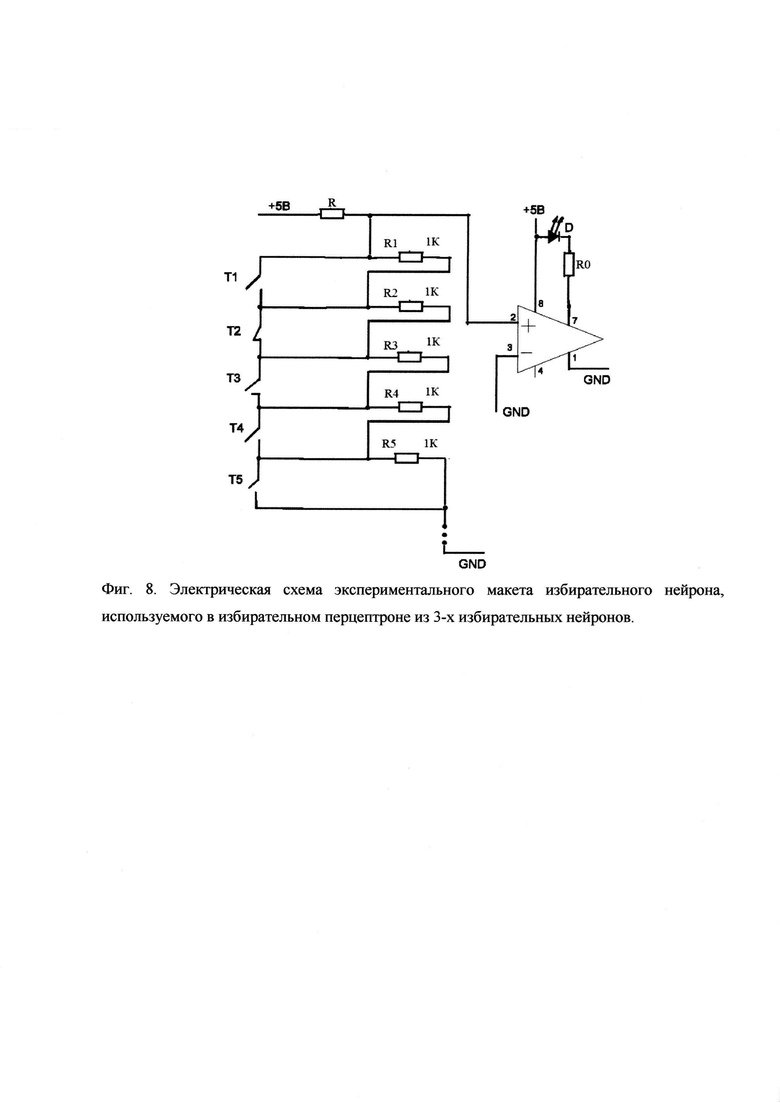

Осуществление изобретения было реализовано в виде материального макета («в железе»). Для проверки эффективности метода обучения без математики и без учителя в избирательных нейронных сетях был реализован экспериментальный макет избирательного перцептрона. Электрическая схема показана на фиг. 8.

Фиг. 8. Электрическая схема экспериментального макета избирательного нейрона, используемого в избирательном перцептроне из 3-х избирательных нейронов.

Всего нейрон содержит 9 каналов связи, из которых создаются избирательные кластеры. Пороговое значение суммы напряжений на выходе кластеров равно 5 в. Превышение порогового значения U≥5 приводит к зажиганию индикаторного светодиода D.

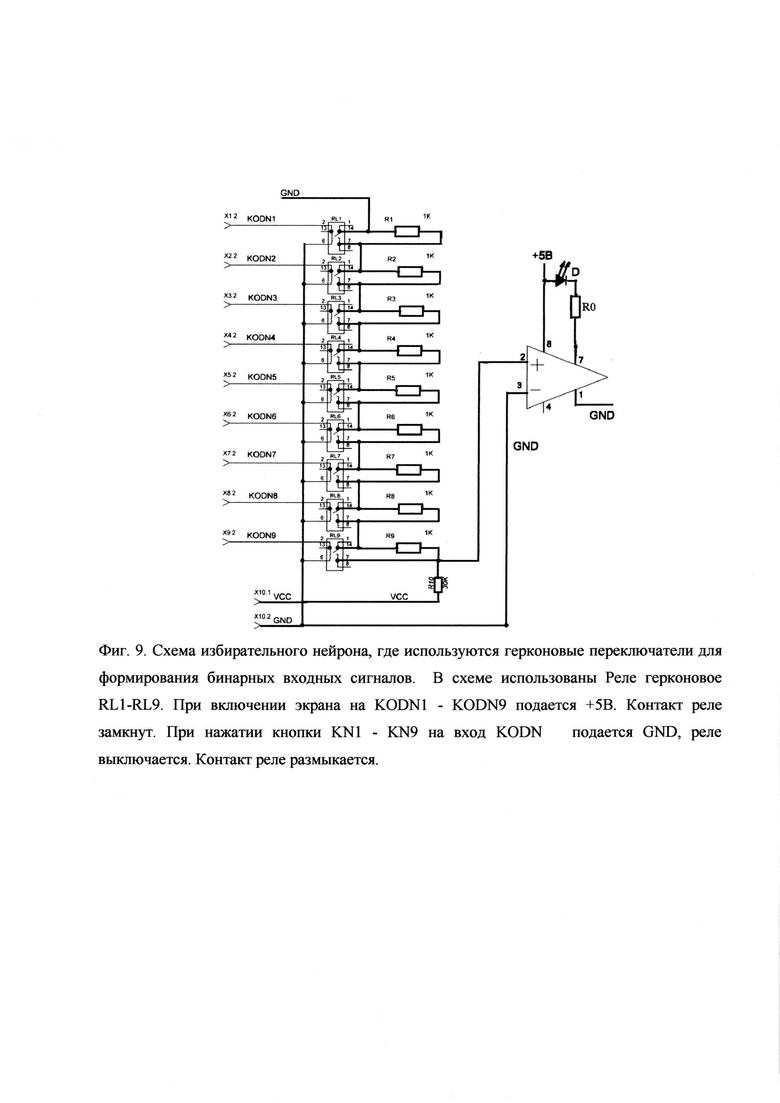

Переключатели Т1-Т9 служат для реализации кластеров каналов связи нейрона. Если переключатель замкнут, то нейронный канал считается заблокированным, в состав нейронного кластера входят не заблокированные каналы связи нейрона. Управление формированием кластеров из каналов связи осуществляется с пульта управления. Более детальная схема избирательного нейрона, где используются герконовые переключатели для формирования бинарных входных сигналов, показана на фиг. 9.

Фиг. 9. Схема избирательного нейрона, где используются герконовые переключатели для формирования бинарных входных сигналов. В схеме использованы Реле герконовое RL1-RL9. При включении экрана на KODN1-KODN9 подается +5 В. Контакт реле замкнут. При нажатии кнопки KN1-KN9 на вход KODN подается GND, реле выключается. Контакт реле размыкается.

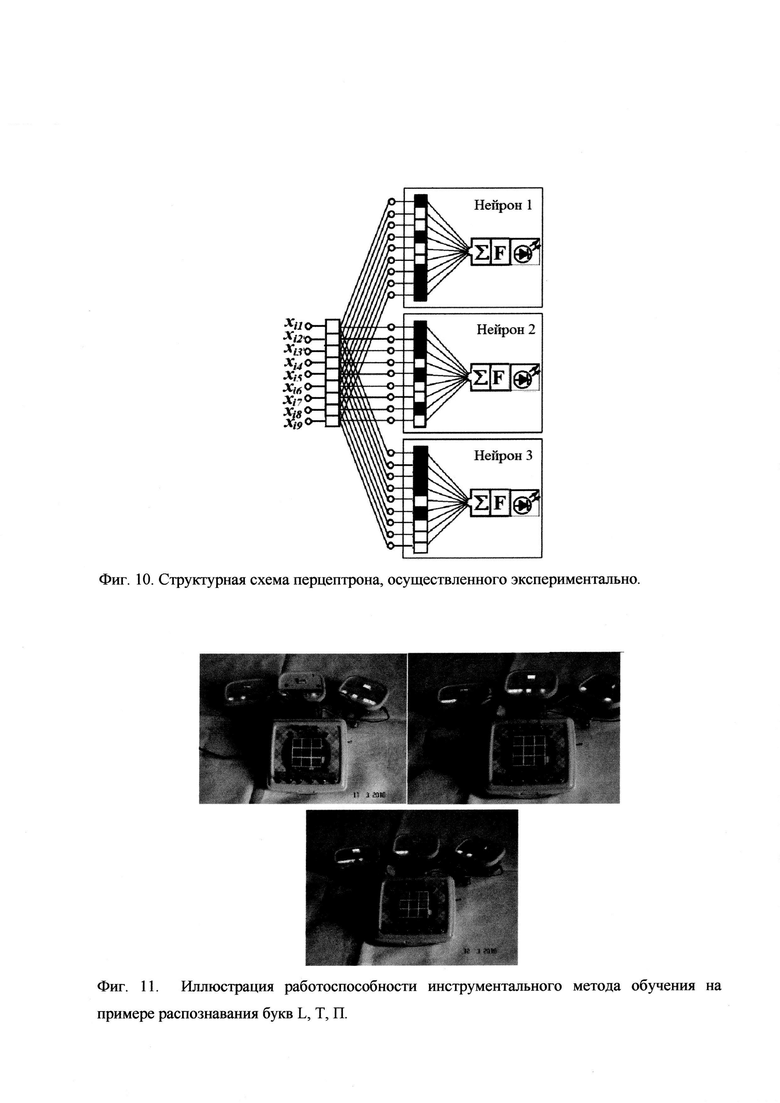

Для проверки изобретения и использования в учебной практике для обучения нейрообразовательным технологиям был разработан однослойный перцептрон с тремя регистрирующими нейронами. Входной сигнал создавался с помощью пульта управления на экране монитора с размерностью 3×3. Входной сигнал представлял бинарную последовательность из 9-ти ячеек, содержащих 0 и 1. Структурная схема разработанного перцептрона показана на фиг. 10.

Фиг. 10. Структурная схема перцептрона, осуществленного экспериментально.

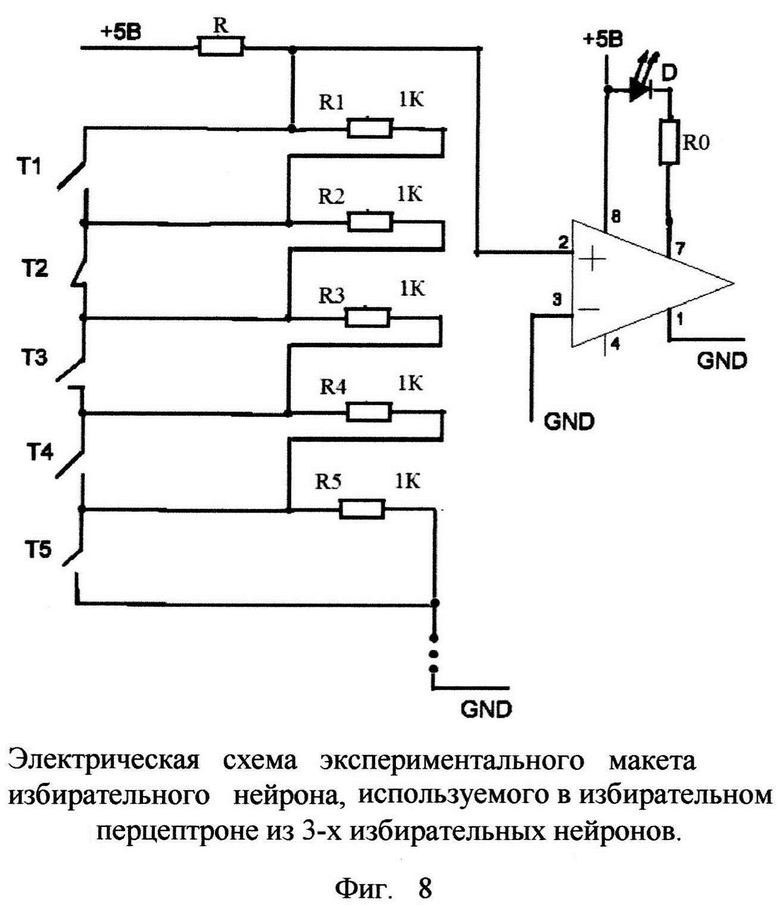

Перцептрон предназначен для распознавания 5-ти пиксельных объектов, в качестве которых были взяты буквы L, Т, П (в качестве входных объектов могли быть взяты любые изображения, содержащие 5 пикселей, равных 1). Входные объекты обозначались xi=(xi1, xi2, xi3) (i=1, 2, 3). Требуемая конфигурация кластеров каналов связи создавалась с помощью соединительных проводников между пультом управления и макетами нейронов. Типы соединений подбирались в соответствии с кодовыми комбинациями букв. Макет содержал пульт управления с монитором 9×9, на котором можно было набрать буквы L, Т, П. Величина порога распознавания Uпор=4.5. Индикация каналов нейронных кластеров производилась дополнительно с помощью 9-ти красных светящихся светодиодов (на принципиальной схеме фиг. 9 эти светодиоды не показаны). Эти диоды идентифицируют порядковые номера каналов кластеров. Индикаторный диод, показанный в схемах фиг. 8 и фиг. 9, имел зеленый цвет. Сумма напряжений на индикаторном диоде равна сумме единиц в кодовой комбинации буквы и равна 5 для нейрона, настроенного на эту букву. На других нейронах сумма напряжений равна 2 и 3, что не вызывает превышения порога и индикатор зеленого цвета не горит. Величину напряжения на индикаторных диодах можно оценить по количеству зажженных красных вспомогательных светодиодов. Пример распознавания букв L, Т, П. иллюстрируется фиг. 11.

Фиг. 11. Иллюстрация работоспособности инструментального метода обучения на примере распознавания букв L, Т, П.

Набор распознаваемых бинарных последовательностей производится на пульте управления, создание кластеров каналов связи производится с помощью соединительных электрических проводов, имитирующих каналы связи нейрона - дендриты. Кластеры каналов связи идентифицируются светящимися лампочками в нижней части нейронов, моделируемых блоками, показанными на верхней части рисунка. Так при распознавании буквы L на первом слайде сверху буква L распознается правым блоком, на котором имеется 5 каналов связи, что приводит к загоранию индикаторного светодиода зеленым цветом, что видно на фотографии. На левом и среднем блоках задействованы соответственно 2 и 3 канала связи, что не приводит к загоранию индикаторных светодиодов на этих блоках - нейронах. Аналогичные процессы происходят при наборе букв Т и П.

В качестве реальных приложений рассматриваемого метода инструментального обучения без математики при использовании избирательных нейросетевых технологий можно рассматривать задачи при сравнительно небольшом количестве распознаваемых или управляемых объектов. В качестве таких примеров можно привести исследование безопасности режимов работы атомных электростанций, управление режимами работы энергетических установок, управления роботами, в учебной работе по изучению нейронных сетей и нейротехнологий.

Перечень фигур

Фиг. 1. Структурная схема процесса обучения нейронной сети.

Фиг. 2. Структура процесса обучения на примере двухслойного перцептрона.

Фиг. 3. Структура избирательного нейрона (справа) и нейрона МакКаллока-Питтса (слева).

Фиг. 4. Структура однослойного перцептрона Розенблюта, использующего нейроны МакКаллока-Питтса, и избирательного перцептрона слева и справа.

Фиг. 5. Известная структурная схема обучения нейронной сети типа однослойного или многослойного перцептрона на основе нейронов МакКаллока-Питтса. На рисунке W - матрица весовых коэффициентов; Wx - умножение матрицы весовых коэффициентов на матрицу входных векторов.

Фиг. 6. Структурная схема материального устройства, реализующего предлагаемый инструментальный способ обучения избирательной нейронной сети. На рисунке K - матрица, характеризующая избирательный кластер, получаемый инструментальным преобразованием из входных векторов.

Фиг. 7. Структура материального устройства, реализующего инструментальный метод обучения избирательной нейронной сети.

Фиг. 8. Электрическая схема экспериментального макета избирательного нейрона, используемого в избирательном перцептроне из 3-х избирательных нейронов.

Фиг. 9. Схема избирательного нейрона, где используются герконовые переключатели для формирования бинарных входных сигналов. В схеме использованы Реле герконовое RL1-RL9. При включении экрана на KODN1-KODN9 подается +5 В. Контакт реле замкнут. При нажатии кнопки KN1-KN9 на вход KODN подается GND, реле выключается. Контакт реле размыкается.

Фиг. 10. Структурная схема перцептрона, осуществленного экспериментально.

Фиг. 11. Иллюстрация работоспособности инструментального метода обучения на примере распознавания букв L, Т, П.

Список литературы

1. Александров Ю.И., Анохин К.В., Соколов Е.Н., Греченко Т.Н. и др. Нейрон. Обработка сигналов. Пластичность. Моделирование. Фундаментальное руководство. Изд-во Тюменского государственного университета. 2008. 548 с.

2. Борисюк Г.Н., Борисюк P.M., Казанович Я.Б., Иваницкий Г.Р. Модели динамики нейронной активности при обработке информации мозгом - итоги "десятилетия". Успехи физических наук. 2002. Т. 172 №10. С. 1189-1214.

3. Греченко Т.Н. Психофизиология. М.: Гардарики, 2009. 572 с.

4. Хайкин С. Нейронные сети: полный курс. 2-е изд. М., "Вильямс", 2006.

5. Галушкин А.И. Нейронные сети. Основы теории. М., Горячая линия - Телеком, 2010.

6. Ежов А.А., Шумский С.А. Нейрокомпьютинг и его применения в экономике и бизнесе. М., МИФИ, 1998.

7. Чернавский Д.С. Синергетика и информация: Динамическая теория информации. 2-е изд. М.: УРСС. 2004.

8. Анохин К.В. "Нейронные механизмы памяти: синаптическая и геномная гипотезы", Журнал высшей нервной деятельности им. И.П. Павлова, 2011. N 6. С. 660-674.

9. Нейронные сети. Statistica Neural Networks. Методология и технологии современного анализа данных; Горячая Линия - Телеком -, 2008. - 392 с.

10. Редько В.Г. Эволюция, нейронные сети, интеллект. Модели и концепции эволюционной кибернетики; Либроком - Москва, 2013. - 224 с.

11. Melamed О., Gerstner W., Maass W., Tsodyks M., Markram H. Coding and learning of behavioral sequences // Trends in Neurosciences, 2004, V. 27, №1, pp. 11-14.

12. Цуриков A.H. Способ обучения искусственной нейронной сети G06N 3/08. 2504006. 2014.

13. Минин А., Мохов И. Способ компьютеризованного обучения одной или более нейронных сетей. G06N 3/00. 2459254. 2012.

14. Сальников B.C., Анцев А.В., Хоанг Ван Чи. Способ обучения искусственной нейронной сети. G06N 3/08. 2566979. 2015.

15. Гладков А.А., Пимашкин А.С., Мухина И.В., Кастальский И.А., Казанцев В.Б. Способ обучения биологической нейронной сети культуры, выращенной на мультиэлектродной матрице. G06N. 2553947. 2015.

16. Мазуров М.Е. Нейрон, моделирующий свойства реального нейрона. Патент на изобретение №2597495. 07.11.2014.

17. Мазуров М.Е. Однослойный перцептрон на основе избирательных нейронов. Патент на изобретение №2597497 13.01.2015.

18. Мазуров М.Е. Синхронизация релаксационных автоколебательных систем, синхронизация в нейронных сетях. Изв. РАН. Сер. физ. 2018. Т. 82. №1. С. 83-87.

19. Мазуров М.Е. "Избирательные нейронные сети для распознавания сложных объектов." В: Математическая биология и биоинформатика: труды VI Международная конф. М.: МАКС Пресс. 2016. С. 82-83.

20. Мазуров М.Е. Нелинейная динамика, почти-периодическое суммирование, автоколебательные процессы, информационное кодирование в избирательных импульсных нейронных сетях // Изв. РАН. Серия физическая, 2018, том 82, №11, с. 1564-1570

21. Mazurov, ME.: Intelligent Recognition of Electrocardiograms Using Selective Neuron Networks and Deep Learning. // International Conference of Artificial Intelligence, Medical Engineering, Education. Moscow, Russia. 2017, 182-198

22. Mazurov, ME.: Modeling of Intellect with the use of Complex Conditional Reflexes and Selective Neural Network Technologies // International Conference of Artificial Intelligence, Medical Engineering, Education. Moscow, Russia. 2018, 365-376

| название | год | авторы | номер документа |

|---|---|---|---|

| Эффективный перцептрон на основе нейронов МакКаллока-Питтса с использованием компараторов | 2019 |

|

RU2729554C1 |

| ОДНОСЛОЙНЫЙ ПЕРЦЕПТРОН НА ОСНОВЕ ИЗБИРАТЕЛЬНЫХ НЕЙРОНОВ | 2015 |

|

RU2597497C2 |

| Способ кодирования информации в импульсных нейронных сетях | 2019 |

|

RU2748257C2 |

| НЕЙРОН, МОДЕЛИРУЮЩИЙ СВОЙСТВА РЕАЛЬНОГО НЕЙРОНА | 2014 |

|

RU2597495C2 |

| ОДНОСЛОЙНЫЙ ПЕРЦЕПТРОН, МОДЕЛИРУЮЩИЙ СВОЙСТВА РЕАЛЬНОГО ПЕРЦЕПТРОНА | 2015 |

|

RU2597496C1 |

| ИМПУЛЬСНЫЙ НЕЙРОН, БЛИЗКИЙ К РЕАЛЬНОМУ | 2015 |

|

RU2598298C2 |

| Модель нейрона, основанная на дендритных вычислениях | 2021 |

|

RU2777262C1 |

| СПОСОБ ДИАГНОСТИРОВАНИЯ ИНФОРМАЦИОННО-ПРЕОБРАЗУЮЩИХ ЭЛЕМЕНТОВ БОРТОВОГО ОБОРУДОВАНИЯ ВОЗДУШНОГО СУДНА НА ОСНОВЕ МАШИННОГО ОБУЧЕНИЯ | 2022 |

|

RU2802976C1 |

| МОДЕЛЬ НЕЙРОНА, РЕАЛИЗУЮЩАЯ ЛОГИЧЕСКУЮ ФУНКЦИЮ НЕРАВНОЗНАЧНОСТИ | 2003 |

|

RU2269155C2 |

| Способ выявления объектов на изображении плана-схемы объекта строительства | 2022 |

|

RU2785821C1 |

Изобретение относится к способу обучения бинарной нейронной сети для распознавания объектов. Технический результат заключается в повышении эффективности обучения нейронной сети. В способе инструментально без использования вычислительных методов и учителя создают систему кластеров каналов связи регистрирующих нейронов, для чего значимые каналы связи регистрирующих нейронов соединяют с информативно значимыми элементами - каналами связи входных бинарных последовательностей - кодовых комбинаций, то есть настраивают каждый регистрирующий нейрон на информативные свойства входных сигналов; выравнивают значения интегральных сумм, поступающих на регистрирующие нейроны через каналы связи от входных объектов; при добавлении новых объектов синхронно изменяют пороговое значение нелинейной пороговой функции регистрирующих нейронов. 11 ил.

Способ обучения бинарной нейронной сети для распознавания объектов, когда используют подбор весовых коэффициентов на основе обучающей базы данных, учителя и использования вычислительных методов,

отличающийся тем, что

инструментально без использования вычислительных методов и учителя создают систему кластеров каналов связи регистрирующих нейронов,

для чего значимые каналы связи регистрирующих нейронов соединяют с информативно значимыми элементами - каналами связи входных бинарных последовательностей - кодовых комбинаций, то есть

настраивают каждый регистрирующий нейрон на информативные свойства входных сигналов;

выравнивают значения интегральных сумм, поступающих на регистрирующие нейроны через каналы связи от входных объектов;

при добавлении новых объектов синхронно изменяют пороговое значение нелинейной пороговой функции регистрирующих нейронов.

| СПОСОБ ОБУЧЕНИЯ ИСКУССТВЕННОЙ НЕЙРОННОЙ СЕТИ | 2012 |

|

RU2504006C1 |

| ОДНОСЛОЙНЫЙ ПЕРЦЕПТРОН НА ОСНОВЕ ИЗБИРАТЕЛЬНЫХ НЕЙРОНОВ | 2015 |

|

RU2597497C2 |

| Копер с бесконечной цепью для подъема бабы | 1930 |

|

SU20012A1 |

| US 9792547 B2, 17.10.2017 | |||

| Токарный резец | 1924 |

|

SU2016A1 |

| US 9633282 B2, 25.04.2017 | |||

| US 9317779 B2, 19.04.2016. | |||

Авторы

Даты

2020-08-13—Публикация

2019-01-21—Подача