Вводные примечания

Ниже описаны различные варианты осуществления и аспекты согласно изобретению. Кроме того, дополнительные варианты осуществления определены прилагаемой формулой изобретения. Следует отметить, что любые варианты осуществления, определяемые формулой изобретения, могут быть дополнены любыми из подробностей (признаков и функциональностей), приведенных в данном описании.

Кроме того, варианты осуществления, приведенные в данном описании, могут использоваться по отдельности, а также могут дополняться любыми из признаков в данном документе или любым признаком, включенным в формулу изобретения.

Кроме того, следует отметить, что отдельные аспекты, описанные в данном документе, могут использоваться по отдельности или в сочетании. Таким образом, подробности могут быть добавлены в каждый из упомянутых отдельных аспектов без добавления подробностей в другой из упомянутых аспектов.

Также следует отметить, что в настоящем описании явно или неявно описаны признаки, применимые в генераторе аудиоданных и/или в способе и/или в компьютерном программном продукте. Таким образом, любой из признаков, описанных в данном документе, может использоваться в контексте устройства, способа и/или компьютерного программного продукта.

Кроме того, признаки и функциональности, раскрытые в данном документе по отношению к способу, также могут использоваться в устройстве (выполненном с возможностью реализации такой функциональности). Кроме того, любые признаки и функциональности, раскрытые в данном документе в отношении устройства, также могут использоваться в соответствующем способе. Другими словами, способы, раскрытые в данном документе, могут быть дополнены любыми из признаков и функциональностей, описанных в отношении устройств.

Кроме того, любые из признаков и функциональностей, описанных в данном документе, могут быть реализованы в аппаратных средствах или в программном обеспечении либо с использованием сочетания аппаратных средств и программного обеспечения, как описано в разделе «Альтернативные варианты реализации».

Альтернативные варианты реализации

При том, что некоторые аспекты описаны в контексте устройства, очевидно, что эти аспекты также представляют собой описание соответствующего способа, при этом признак соответствует этапу способа либо признаку этапа способа. Аналогичным образом, аспекты, описанные в контексте этапа способа, также представляют собой описание соответствующего признака соответствующего устройства. Некоторые или все этапы способа могут выполняться аппаратным устройством, таким как, например, микропроцессор, программируемый компьютер либо электронная схема (или с их использованием). В некоторых вариантах осуществления один или более из самых важных этапов способа могут выполняться этим устройством.

В зависимости от определенных требований к реализации, варианты осуществления изобретения могут быть реализованы в аппаратных средствах или в программном обеспечении. Реализация может выполняться с использованием цифрового носителя данных, например гибкого диска, DVD, Blu-Ray, CD, ROM, PROM, E PROM, EEPROM или флэш-памяти, имеющего сохраненные считываемые электронными средствами управляющие сигналы, которые взаимодействуют (или допускают взаимодействие) с программируемой компьютерной системой таким образом, что осуществляется соответствующий способ. Следовательно, цифровой носитель данных может быть машиночитаемым.

Некоторые варианты осуществления согласно изобретению содержат носитель данных, имеющий считываемые электронными средствами управляющие сигналы, которые допускают взаимодействие с программируемой компьютерной системой таким образом, что осуществляется один из способов, описанных в данном документе.

В общем, варианты осуществления настоящего изобретения могут быть реализованы в виде компьютерного программного продукта с программным кодом, при этом программный код выполнен с возможностью осуществления одного из способов, когда компьютерный программный продукт выполняется на компьютере. Программный код может сохраняться, например, на машиночитаемом носителе.

Другие варианты осуществления содержат компьютерную программу для осуществления одного из способов, описанных в данном документе, сохраненную на машиночитаемом носителе.

Другими словами, вариант осуществления способа согласно изобретению, таким образом, этого представляет собой компьютерную программу, имеющую программный код для осуществления одного из способов, описанных в данном документе, когда компьютерная программа выполняется на компьютере.

Следовательно, дополнительный вариант осуществления способов согласно изобретению представляет собой носитель данных (цифровой носитель данных или машиночитаемый носитель), содержащий записанную компьютерную программу для осуществления одного из способов, описанных в данном документе. Носитель данных, цифровой носитель данных или носитель с записанными данными обычно является материальным и/или постоянным.

Следовательно, дополнительный вариант осуществления способа согласно изобретению представляет собой поток данных или последовательность сигналов, представляющих компьютерную программу для осуществления одного из способов, описанных в данном документе. Поток данных или последовательность сигналов, например, может быть выполнен с возможностью передачи через соединение для передачи данных, например, через Интернет.

Дополнительный вариант осуществления содержит средство обработки, например, компьютер или программируемое логическое устройство, выполненное или адаптированное с возможностью осуществления одного из способов, описанных в данном документе.

Дополнительный вариант осуществления содержит компьютер, имеющий установленную компьютерную программу для осуществления одного из способов, описанных в данном документе.

Дополнительный вариант осуществления согласно изобретению содержит устройство или систему, выполненную с возможностью передачи (например, электронными или оптическими средствами) компьютерной программы для осуществления одного из способов, описанных в данном документе, в приемное устройство. Приемное устройство, например, может представлять собой компьютер, мобильное устройство, запоминающее устройство и т.п. Устройство или система, например, может содержать файловый сервер для передачи компьютерной программы в приемное устройство.

В некоторых вариантах осуществления может использоваться программируемое логическое устройство (например, программируемая пользователем вентильная матрица) для того, выполнения части или всех из функциональностей способов, описанных в данном документе. В некоторых вариантах осуществления программируемая пользователем вентильная матрица может взаимодействовать с микропроцессором для осуществления одного из способов, описанных в данном документе. В общем случае, способы предпочтительно осуществляются любым аппаратным устройством.

Устройства, описанные в данном документе, могут быть реализованы с использованием аппаратного устройства либо с использованием компьютера, либо с использованием сочетания аппаратного устройства и компьютера.

Устройства, описанные в данном документе, или любые компоненты устройств, описанных в данном документе, могут быть реализованы по меньшей мере частично в аппаратных средствах и/или в программном обеспечении.

Способы, описанные в данном документе, могут осуществляться с использованием аппаратного устройства либо с использованием компьютера, либо с использованием сочетания аппаратного устройства и компьютера.

Способы, описанные в данном документе или любая часть способов, описанных в данном документе, могут выполняться по меньшей мере частично аппаратными средствами и/или программным обеспечением.

Вышеописанные варианты осуществления являются лишь иллюстрацией принципов настоящего изобретения. Следует понимать, что специалистам в данной области техники должны быть очевидны модификации и изменения конфигураций и подробностей, описанных в данном документе. Следовательно, подразумевается ограничение лишь объемом нижеприведенной формулы изобретения, но не конкретными подробностями, представленными в данном документе в качестве описания и пояснения вариантов осуществления.

Область техники, к которой относится изобретение

Изобретение относится к области техники формирования аудиоданных.

Варианты осуществления изобретения относятся к генератору аудиоданных, выполненному с возможностью формирования аудиосигнала из входного сигнала и целевых данных, причем целевые данные представляют аудиосигнал. Дополнительные варианты осуществления относятся к способам формирования аудиосигнала и к способам обучения генератора аудиоданных. Дополнительные варианты осуществления относятся к компьютерному программному продукту.

Уровень техники

В последние годы, нейронные вокодеры превосходят классические подходы к синтезу речи с точки зрения естественности и воспринимаемого качества синтезированных речевых сигналов. Наилучшие результаты могут достигаться посредством вычислительно емких нейронных вокодеров, таких как WaveNet и WaveGlow, тогда как легкие архитектуры на основе генеративно-состязательных сетей, например, MelGAN и Parallel WaveGAN, по-прежнему являются низкокачественными с точки зрения воспринимаемого качества.

Генеративные модели с использованием глубокого обучения для формирования форм аудиосигнала, такие как WaveNet, LPCNet и WaveGlow, обеспечивают существенные усовершенствования в естественно звучащем синтезе речи. Эти генеративные модели, называемые в вариантах применения для преобразования текста в речь (TTS) «нейронными вокодерами», превосходят способы как параметрического, так и конкатенативного синтеза. Они могут обусловливаться с использованием сжатых представлений целевой речи (например, мел-спектрограммы) для воспроизведения определенного говорящего и определенного речевого фрагмента.

Предыдущие работы продемонстрировали, что кодирование речи на очень низкой скорости передачи битов для чистой речи может достигаться с использованием таких генеративных моделей на стороне декодера. Это может осуществляться посредством обуславливания нейронных вокодеров с параметрами из классического речевого кодера с низкой скоростью передачи битов.

Нейронные вокодеры также используются для задач улучшения речи, таких как очистка от шума или дереверберация речи.

Основная проблема этих глубоких генеративных моделей обычно заключается в высоком числе требуемых параметров и результирующей сложности в ходе обучения и синтеза (логического вывода). Например, WaveNet, рассматриваемый в качестве уровня техники для качества синтезированной речи, формирует последовательно аудиовыборки одну за другой. Этот процесс является очень медленным и вычислительно емким и не может выполняться в реальном времени.

В последнее время, легкие состязательные вокодеры на основе генеративно-состязательных сетей (GAN), такие как MelGAN и Parallel WaveGAN, предложены для быстрого образования форм сигналов. Тем не менее, сообщенное воспринимаемое качество речи, сформированной с использованием этих моделей, значительно ниже стандарта нейронных вокодеров, таких как WaveNet и WaveGlow. Для ликвидации этого разрыва в качестве предложена GAN для преобразования текста в речь (GAN-TTS), но она все же сопряжена с высокими вычислительными затратами.

Существует огромное множество нейронных вокодеров, все из которых имеют недостатки. Авторегрессивные вокодеры, например, WaveNet и LPCNet, могут иметь очень высокое качество и быть подходящими для оптимизации для логического вывода на CPU, но они не являются подходящими для использования на GPU, поскольку их обработка не может параллелизоваться легко, и они не могут предлагать обработку не в реальном времени без ухудшения качества.

Нормализующие потоковые вокодеры, например, WaveGlow, также могут иметь очень высокое качество и быть подходящими для логического вывода на GPU, но они содержат очень сложную модель, для обучения и оптимизации которой требуется длительное время; она также является неподходящей для встроенных устройств.

Вокодеры GAN, например, MelGAN и Parallel WaveGAN, могут быть пригодными для логического вывода на GPU и легкими, но их качество ниже авторегрессивных моделей.

В общих словах, по-прежнему отсутствует решение с низкой сложностью, которое обеспечивало бы высококачественную речь. GAN представляет собой наиболее изученный подход для решения такой задачи. Настоящее изобретение представляет собой эффективное решение для этой проблемы.

Задача настоящего изобретения состоит в создании решения на основе легкого нейронного вокодера, который формирует речь с очень высоким качеством и является обучаемым при ограниченных вычислительных ресурсах, например для TTS (преобразования текста в речь).

Краткое описание чертежей

Ниже описаны варианты осуществления согласно настоящему изобретению с обращением к сопровождающим чертежам, на которых:

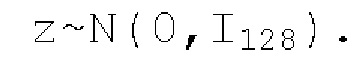

На Фиг. 1 показана архитектура генератора аудиоданных согласно вариантам осуществления настоящего изобретения,

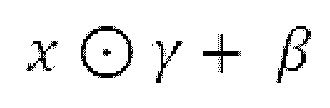

На Фиг. 2 показана структура дискриминатора, который может использоваться для обучения генератора аудиоданных согласно настоящему изобретению,

На Фиг. 3 показана структуруа части генератора аудиоданных согласно вариантам осуществления настоящего изобретения,

На Фиг. 4 показана структура части генератора аудиоданных согласно вариантам осуществления настоящего изобретения, и

На Фиг. 5 показаны результаты экспертного теста MUSHRA на основе прослушивания различных моделей.

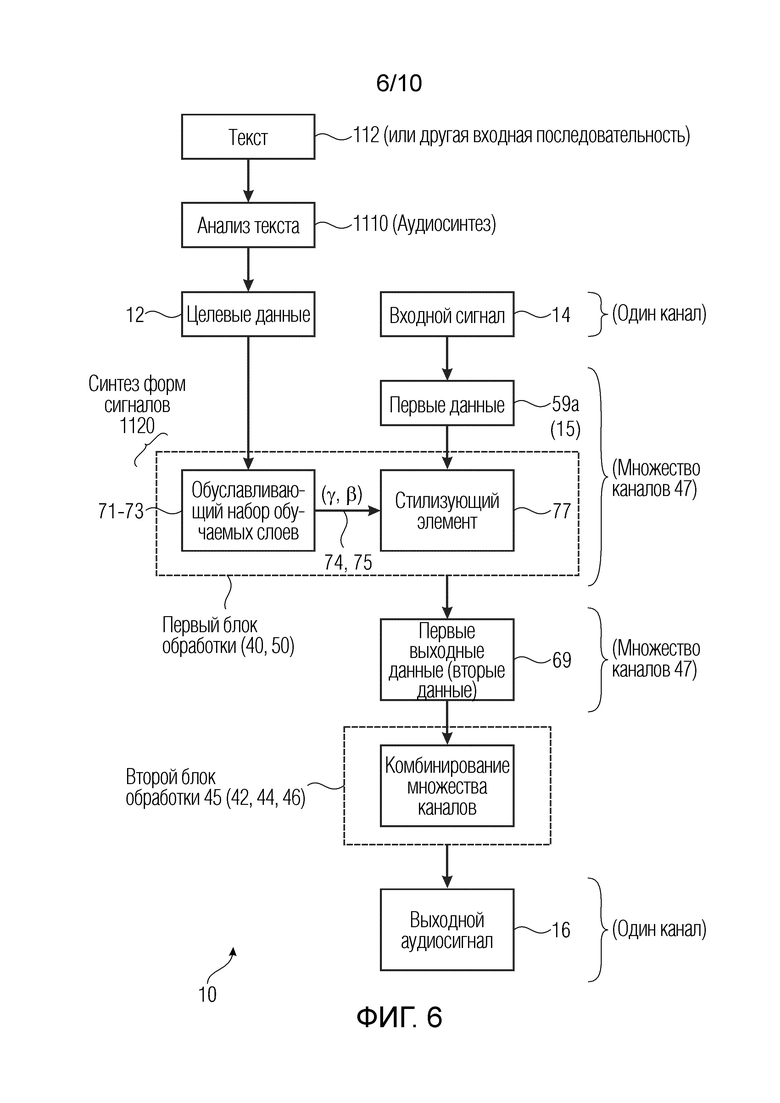

На Фиг. 6 показана архитектура генератора аудиоданных согласно вариантам осуществления настоящего изобретения.

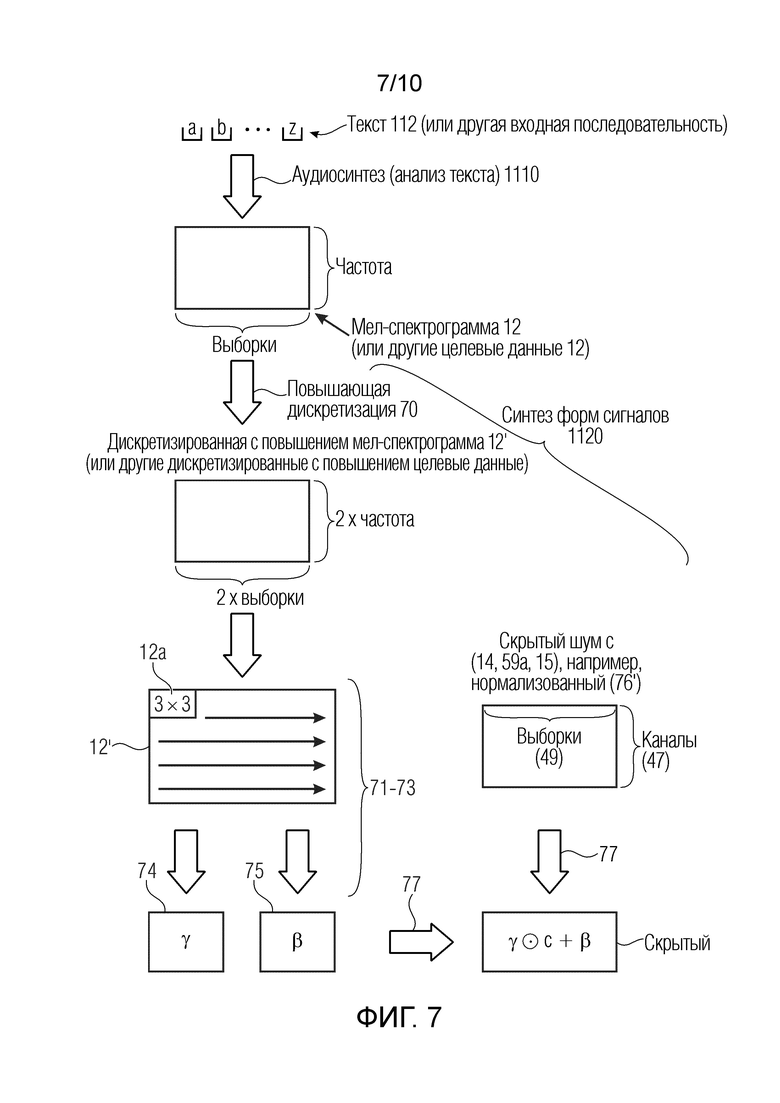

На Фиг. 7 показаны операции, которые выполняются для сигналов согласно изобретению.

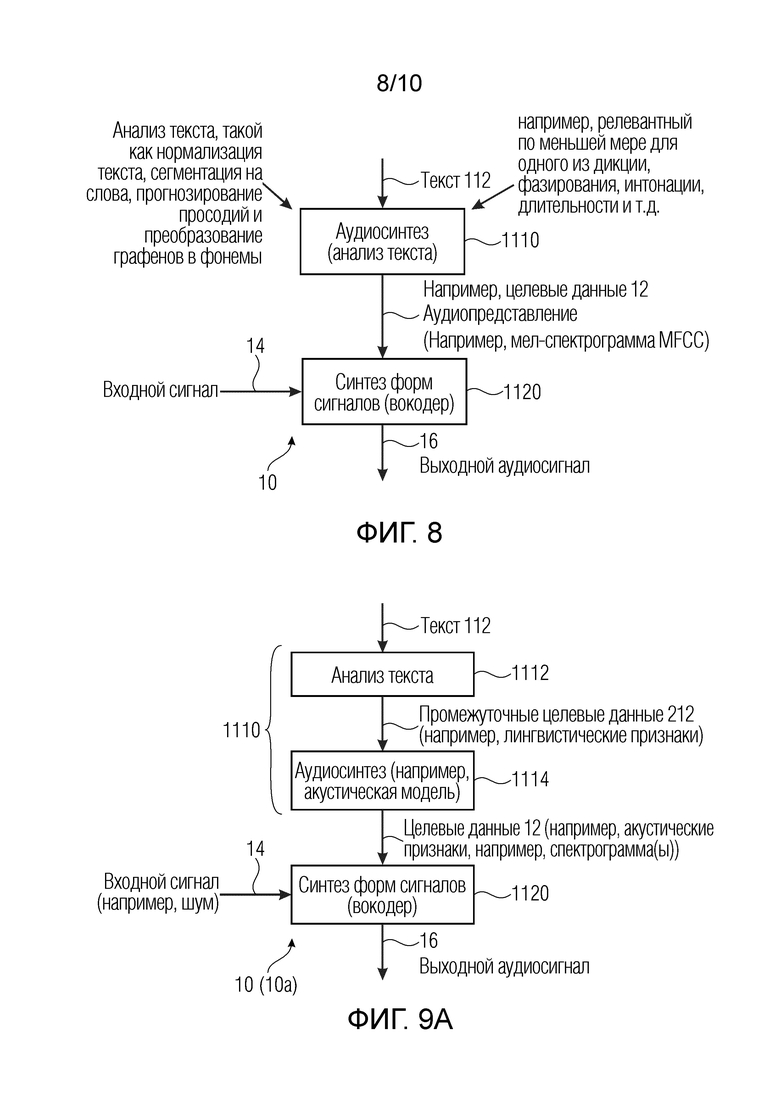

На Фиг. 8 показаны операции в варианте применения для преобразования текста в речь с использованием генератора аудиоданных.

На Фиг. 9а-9с показаны примеры генераторов.

На Фиг. 10 показано несколько возможностей для вводов и выводов блока, который может быть внутренним или внешним по отношению к генератору согласно изобретению.

На чертежах аналогичные ссылочные позиции обозначают аналогичные элементы и признаки.

Раскрытие изобретения

В соответствии с аспектом, предусмотрен генератор аудиоданных, выполненный с возможностью формирования аудиосигнала из входного сигнала и целевых данных, причем целевые данные представляют аудиосигнал, содержащий:

- первый блок обработки, выполненный с возможностью приема первых данных, извлекаемых из входного сигнала, и вывода первых выходных данных, при этом первые выходные данные содержат множество каналов, и

- второй блок обработки, выполненный с возможностью приема первых выходных данных или данных, извлекаемых из первых выходных данных, в качестве вторых данных,

- при этом первый блок обработки содержит для каждого канала первых выходных данных:

- обуславливающий набор обучаемых слоев, выполненных с возможностью обработки целевых данные для получения параметров обуславливающих признаков, причем целевые данные извлекаются из текста; и

- стилизующий элемент, выполненный с возможностью применения параметров обуславливающих признаков к первым данным или к нормализованным первым данным; и

- при этом второй блок обработки выполнен с возможностью комбинирования множества каналов вторых данных для получения аудиосигнала.

Генератор аудиоданных может быть таким, что целевые данные представляют собой спектрограмму. Генератор аудиоданных может быть таким, что целевые данные представляют собой мел-спектрограмму.

Генератор аудиоданных может быть таким, что целевые данные содержат по меньшей мере один акустический признак из логарифмической спектрограммы или MFCC и мел-спектрограммы или другого типа спектрограммы, полученной из текста.

Генератор аудиоданных может быть выполнен с возможностью получения целевых данных посредством преобразования ввода в форме текста или элементов текста по меньшей мере в один акустический признак.

Генератор аудиоданных может быть выполнен с возможностью получения целевых данных посредством преобразования по меньшей мере одного лингвистического признака по меньшей мере в один акустический признак.

Генератор аудиоданных может содержать по меньшей мере один лингвистический признак из фонемы, просодии слов, интонации, разрывов фраз и заполненных пауз, полученных из текста.

Генератор аудиоданных может быть выполнен с возможностью получения целевых данных посредством преобразования ввода в форме текста или элементов текста по меньшей мере в один лингвистический признак.

Генератор аудиоданных может быть таким, что целевые данные содержат по меньшей мере одно из символа и слова, полученного из текста.

Генератор аудиоданных может быть таким, что целевые данные извлекаются из текста с использованием статистической модели, выполняющей анализ текста и/или использующей акустическую модель.

Генератор аудиоданных может быть таким, что целевые данные извлекаются из текста с использованием обучаемой модели, выполняющей анализ текста и/или использующей акустическую модель.

Генератор аудиоданных может быть таким, что целевые данные извлекаются из текста с использованием алгоритма на основе правил, выполняющего анализ текста и/или акустическую модель.

Генератор аудиоданных может быть выполнен с возможностью получения целевых данных посредством подробного анализа ввода.

Генератор аудиоданных может быть выполнен с возможностью извлечения целевых данных по меньшей мере через один детерминированный слой.

Генератор аудиоданных может быть выполнен с возможностью извлечения целевых данных по меньшей мере через один обучаемый слой.

Генератор аудиоданных может быть таким, что обуславливающий набор обучаемых слоев состоит из одного или по меньшей мере двух сверточных слоев.

Генератор аудиоданных может быть таким, что первый сверточный слой выполнен с возможностью свертывания целевых данных или дискретизированных с повышением целевых данных для получения первых свернутых данных с использованием первой активирующей функции.

Генератор аудиоданных может быть таким, что обуславливающий набор обучаемых слоев и стилизующий элемент представляют собой часть слоя весовых коэффициентов в остаточном блоке нейронной сети, содержащей один или более остаточных блоков.

Способ может содержать по меньшей мере один акустический признак из логарифмической спектрограммы или MFCC и мел-спектрограммы или другого типа спектрограммы, полученной из текста.

Способ может получать целевые данные посредством преобразования ввода в форме текста или элементов текста по меньшей мере в один акустический признак.

Способ может получать целевые данные посредством преобразования по меньшей мере одного лингвистического признака по меньшей мере в один акустический признак.

Способ может содержать по меньшей мере один лингвистический признак из фонемы, просодии слов, интонации, разрывов фраз и заполненных пауз, полученных из текста.

Способ может получать целевые данные посредством преобразования ввода в форме текста или элементов текста по меньшей мере в один лингвистический признак.

Способ может содержать по меньшей мере одно из символа и слова, полученного из текста.

Способ может извлекать целевые данные посредством использования статистической модели, выполняющей анализ текста и/или использующей акустическую модель.

Способ может извлекать целевые данные посредством использования обучаемой модели, выполняющей анализ текста и/или использующей акустическую модель.

Способ может извлекать целевые данные посредством использования алгоритма на основе правил, выполняющего анализ текста и/или акустическую модель.

Способ может извлекать целевые данные по меньшей мере через один детерминированный слой.

Способ может извлекать целевые данные по меньшей мере через один обучаемый слой.

Способ формирования аудиосигнала дополнительно может содержать извлечение целевых данных из текста.

Способ может включать в себя то, что входная репрезентативная последовательность представляет собой текст.

Способ может включать в себя то, что входная репрезентативная последовательность представляет собой

спектрограмму. Способ может включать в себя то, что спектрограмма представляет собой мел-спектрограмму.

В числе прочего, предложен генератор аудиоданных (например, 10), выполненный с возможностью формирования аудиосигнала (например, 16) из входного сигнала (например, 14) и целевых данных (например, 12), причем целевые данные (например, 12), представляют аудиосигнал (например, 16), и которые могут быть извлечены из текста, содержащий по меньшей мере одно из следующего:

- первый блок обработки (например, 40, 50, 50a-50h), выполненный с возможностью приема первых данных (например, 15, 59а), извлекаемых из входного сигнала (например, 14), и вывода первых выходных данных (например, 69), при этом первые выходные данные (например, 69) содержат множество каналов (например, 47), и

- второй блок обработки (например, 45), выполненный с возможностью приема первых выходных данных (например, 69) или данных, извлекаемых из первых выходных данных (например, 69), в качестве вторых данных.

Первый блок обработки (например, 50) может содержать, для каждого канала первых выходных данных:

- обуславливающий набор обучаемых слоев (например, 71, 72, 73), выполненных с возможностью обработки целевых данных (например, 12) для получения параметров обуславливающих признаков (например, 74, 75); и

- стилизующий элемент (например, 77), выполненный с возможностью применения параметров обуславливающих признаков (например, 74, 75) к первым данным (например, 15, 59а) или к нормализованным первым данным (например, 59, 76').

Второй блок обработки (например, 45) может быть выполнен с возможностью комбинирования множества каналов (например, 47) вторых данных (например, 69) для получения аудиосигнала (например, 16).

Также предложен способ, например, формирования аудиосигнала (например, 16) посредством генератора аудиоданных (например, 10) из входного сигнала (например, 14) и целевых данных (например, 12), причем целевые данные (например, полученные из текста), представляют аудиосигнал (например, 16), содержащий:

- прием первым блоком обработки (например, 50, 50a-50h) первых данных (например, 16559, 59а, 59b), извлекаемых из входного сигнала (например, 14);

- для каждого канала первых выходных данных (например, 59b, 69):

- обработку целевых данных (например, 12), которые могут быть извлечены из текста, обуславливающим набором обучаемых слоев (например, 71, 72, 73) первого блока обработки (например, 50) для получения параметров обуславливающих признаков (например, 74, 75); и

- применение параметров обуславливающих признаков (например, 74, 75) стилизующим элементом (например, 77) первого блока обработки (например, 50) к первым данным (например, 15, 59) или к нормализованным первым данным (например, 76');

- вывод первым блоком обработки (например, 50) первых выходных данных (например, 69), содержащих множество каналов (например, 47);

- прием вторым блоком обработки (например, 45) первых выходных данных (например, 69) или данных, извлекаемых из первых выходных данных (например, 69), в качестве вторых данных; и

- комбинирование множества каналов (например, 47) вторых данных посредством второго блока обработки (например, 45) для получения аудиосигнала (например, 16).

Также предложен способ обучения нейронной сети для формирования аудиоданных, при этом нейронная сеть:

- выводит аудиовыборки с определенным временным шагом из входной последовательности (например, 12), представляющей аудиоданные (например, 16), которые должны формироваться,

- выполнена с возможностью формирования шумового вектора (например, 14) для создания выходных аудиовыборок (например, 16) с использованием входной репрезентативной последовательности (например, 12), и

- обучение конфигурировано с возможностью оптимизации функции потерь (например, 140).

Также предложен способ формирования аудиосигнала (например, 16), содержащего математическую модель, при этом математическая модель выполнена с возможностью вывода аудиовыборок с определенным временным шагом из входной последовательности (например, 12), представляющей аудиоданные (например, 16), которые должны формироваться. Математическая модель может формировать шумовой вектор (например, 14) для создания выходных аудиовыборок с использованием входной репрезентативной последовательности (например, 12).

Именно в этом контексте предложена StyleMelGAN (например, генератор 10 аудиоданных), легкий нейронный вокодер, обеспечивающий синтез высококачественной речи с низкой вычислительной сложностью. StyleMelGAN представляет собой полностью сверточную модель с прямой связью, которая использует временную адаптивную денормализацию (TADE) (например, 60а и 60b на фиг. 4 и 60 на фиг. 3), чтобы стилизовать (например, на 77) низкоразмерный шумовой вектор (например, вектор 128×1) через акустические признаки целевой формы речевого сигнала. Архитектура обеспечивает возможность высокопараллелизуемого формирования, в несколько раз быстрее, чем в реальном времени как на центральных процессорах (CPU), так и на графических процессорах (GPU). Для эффективного и быстрого обучения, можно использовать потери на спектральное восстановление с множеством масштабов вместе с состязательными потерями, вычисленными посредством множества дискриминаторов (например, 132a-132d), оценивающих речевой сигнал 16 во множестве полос частот и со случайным кодированием со взвешиванием (например, в окнах 105а, 105b, 105с, 105d кодирования со взвешиванием). Тесты MUSHRA и Р. 800 на основе прослушивания показывают, что StyleMelGAN (например, генератор 10 аудиоданных) превосходит известные существующие нейронные вокодеры в сценариях синтеза с копированием и в сценариях TTS.

В настоящей заявке предложен, в числе прочего, нейронный вокодер для формирования высококачественной речи 16, который может быть основан на генеративно-состязательной сети (GAN). Решение, называемое в данном документе "StyleMelGAN" (и, например, реализованное в генераторе 10 аудиоданных), представляет собой легкий нейронный вокодер, обеспечивающий синтез высококачественной речи 16 при низкой вычислительной сложности. StyleMelGAN представляет собой полностью сверточную модель с прямой связью, которая использует временную адаптивную денормализацию (TADE) для стилизации (например, в блоке 77) скрытого шумового представления (например, 69) с использованием, например, мел-спектрограммы (12) целевой формы речевого сигнала. Это обеспечивает возможность высокопараллелизуемого формирования, которое выполняется в несколько раз быстрее, чем в реальном времени как на CPU, так и на GPU. Для обучения, можно использовать потери на спектральное восстановление с множеством масштабов с последующими состязательными потерями. Это позволяет получать модель, которая может синтезировать высококачественные выводы менее чем через 2 дня после обучения на одном GPU.

Потенциальные варианты применения и преимущества изобретения заключаются в следующем:

Изобретение может применяться для преобразования текста в речь, и результирующее качество, т.е. сформированное качество речи для TTS и синтеза с копированием, находится близко к WaveNet и естественной речи. Оно также обеспечивает быстрое обучение, так что модель легко и быстро переобучается и персонализируется. Оно использует меньший объем памяти, поскольку оно представляет собой относительно небольшую нейронную сетевую модель. И в завершение, предложенное изобретение обеспечивает выгоду с точки зрения сложности, т.е. оно предусматривает очень хороший компромисс между качеством/сложностью.

Изобретение также может применяться для улучшения речи, причем оно может обеспечивать надежное решение с низкой сложностью для формирования чистой речи из зашумленной.

Изобретение также может применяться для кодирования речи, причем оно может значительно понижать скорость передачи битов посредством передачи только параметров, необходимых для обуславливания нейронного вокодера. Кроме того, в этой заявке решение на основе легкого нейронного вокодера является подходящим для встроенных систем и, в частности, подходящим для планируемого к выпуску (конечного) абонентского устройства (UE), оснащенного GPU или нейронным процессором (NPU).

Варианты осуществления настоящей заявки относятся к генератору аудиоданных, выполненному с возможностью формирования аудиосигнала из входного сигнала и целевых данных, причем целевые данные представляют аудиосигнал (например, из извлеченного текста), содержащему первый блок обработки, выполненный с возможностью приема первых данных, извлекаемых из входного сигнала, и вывода первых выходных данных, при этом первые выходные данные содержат множество каналов, и второй блок обработки, выполненный с возможностью приема первых выходных данных или данных, извлекаемых из первых выходных данных, в качестве вторых данных, при этом первый блок обработки содержит для каждого канала первых выходных данных обуславливающий набор обучаемых слоев, выполненных с возможностью обработки целевых данных для получения параметров обуславливающих признаков; и стилизующий элемент, выполненный с возможностью применения параметров обуславливающих признаков к первым данным или к нормализованным первым данным; и при этом второй блок обработки выполнен с возможностью комбинирования множества каналов вторых данных для получения аудиосигнала.

Согласно одному варианту осуществления, обуславливающий набор обучаемых слоев состоит из одного или двух сверточных слоев.

Согласно одному варианту осуществления, первый сверточный слой выполнен с возможностью свертывания целевых данных или дискретизированных с повышением целевых данных для получения первых свернутых данных с использованием первой активирующей функции.

Согласно одному варианту осуществления, обуславливающий набор обучаемых слоев и стилизующий элемент представляют собой часть слоя весовых коэффициентов в остаточном блоке нейронной сети, содержащей один или более остаточных блоков.

Согласно одному варианту осуществления, генератор аудиоданных дополнительно содержит нормализующий элемент, который выполнен с возможностью нормализации первых данных. Например, нормализующий элемент может нормализовать первые данные в нормальное распределение нулевого среднего и единичной дисперсии.

Согласно одному варианту осуществления, аудиосигнал представляет собой голосовой аудиосигнал.

Согласно одному варианту осуществления, целевые данные дискретизируются с повышением, предпочтительно посредством нелинейной интерполяции, на коэффициент 2 или кратный 2, или степень 2. В некоторых примерах вместо этого может использоваться коэффициент больше 2.

Согласно одному варианту осуществления первый блок обработки дополнительно содержит дополнительный набор обучаемых слоев, выполненных с возможностью обработки данных, извлекаемых из первых данных, с использованием второй активирующей функции, при этом вторая активирующая функция представляет собой стробированную активирующую функцию.

Согласно одному варианту осуществления, дополнительный набор обучаемых слоев состоит из одного или двух (или даже более) сверточных слоев.

Согласно одному варианту осуществления, вторая активирующая функция представляет собой стробированную гиперболическую тангенсную (TanH) функцию мягкого максимума.

Согласно одному варианту осуществления, первая активирующая функция представляет собой функцию на основе текучих единиц линейной ректификации (текучих ReLu).

Согласно одному варианту осуществления, операции свертки выполняются с максимальным коэффициентом растяжения в 2.

Согласно одному варианту осуществления, генератор аудиоданных содержит восемь первых блоков обработки и один второй блок обработки.

Согласно одному варианту осуществления, первые данные имеют более низкую степень размерности, чем аудиосигнал. Первые данные могут иметь первую размерность или по меньшей мере на одну размерность ниже, чем аудиосигнал. Первые данные могут иметь на одну размерность ниже, чем аудиосигнал, но число каналов, большее, чем аудиосигнал. Первые данные могут иметь общее число выборок по всем размерностям ниже, чем в аудиосигнале.

Согласно одному варианту осуществления, целевые данные представляют собой спектрограмму, предпочтительно мел-спектрограмму или поток битов.

Целевые данные могут быть извлечены из текста. Генератор аудиоданных может быть выполнен с возможностью извлечения целевых данных из текста. Целевые данные могут включать в себя, например, по меньшей мере одно из текстовых данных (символы, слова и т.п.), лингвистических признаков, акустических признаков и т.п.

В альтернативных примерах целевые данные могут представлять собой сжатое представление аудиоданных, или целевые данные представляют собой ухудшенный аудиосигнал.

Дополнительные варианты осуществления относятся к способу формирования аудиосигнала посредством генератора аудиоданных из входного сигнала и целевых данных, причем целевые данные представляют аудиосигнал (например, из извлеченного текста), содержащему прием, посредством первого блока обработки, первых данных, извлекаемых из входного сигнала; для каждого канала первых выходных данных, обработку, посредством обуславливающего набора обучаемых слоев первого блока обработки, целевых данных для получения параметров обуславливающих признаков; и применение стилизующим элементом первого блока обработки параметров обуславливающих признаков к первым данным или к нормализованным первым данным; вывод, посредством первого блока обработки, первых выходных данных, содержащих множество каналов; прием, посредством второго блока обработки, в качестве вторых данных, первых выходных данных или данных, извлекаемых из первых выходных данных; и комбинирование вторым блоком обработки множества каналов вторых данных для получения аудиосигнала. В некоторых примерах способ может содержать извлечение целевых данных из текста.

Нормализация может включать в себя, например, нормализацию первых данных в нормальное распределение нулевого среднего и единичной дисперсии.

В способе также может быть предусмотрен любой признак или сочетание признаков генератора аудиоданных.

Дополнительные варианты осуществления относятся к способу обучения генератора аудиоданных, как изложено выше, при этом обучение содержит повторение этапов любого из способов таким образом, как изложено выше, один или более раз.

Согласно одному варианту осуществления, способ обучения дополнительно содержит оценку сформированного аудиосигнала по меньшей мере посредством одного модуля оценки, который предпочтительно представляет собой нейронную сеть, и адаптацию весовых коэффициентов генератора аудиоданных согласно результатам оценки.

Согласно одному варианту осуществления, способ обучения дополнительно содержит адаптацию весовых коэффициентов модуля оценки согласно результатам оценки.

Согласно одному варианту осуществления, обучение содержит оптимизацию функции потерь.

Согласно одному варианту осуществления, оптимизация функции потерь содержит вычисление фиксированного показателя между сформированным аудиосигналом и опорным аудиосигналом.

Согласно одному варианту осуществления, вычисление фиксированного показателя содержит вычисление одного или более спектральных искажений между сформированным аудиосигналом и опорным сигналом.

Согласно одному варианту осуществления, вычисление одного или более спектральных искажений выполняется для абсолютной величины или логарифмической абсолютной величины спектрального представления сформированного аудиосигнала и опорного сигнала и/или для различных временных или частотных разрешений.

Согласно одному варианту осуществления, оптимизация функции потерь содержит извлечение одного или более состязательных показателей посредством случайной подачи и оценки представления сформированного аудиосигнала или представления опорного аудиосигнала посредством одного или более модулей оценки, при этом оценка содержит классификацию подаваемого аудиосигнала на заданное число классов, указывающее предварительно обученный уровень классификации естественности аудиосигнала.

Согласно одному варианту осуществления, оптимизация функции потерь содержит вычисление фиксированного показателя и извлечение состязательного показателя посредством одного или более модулей оценки.

Согласно одному варианту осуществления, генератор аудиоданных сначала обучается с использованием фиксированного показателя.

Согласно одному варианту осуществления, четыре модуля оценки извлекают четыре состязательных показателя.

Согласно одному варианту осуществления, модули оценки работают после разложения представления сформированного аудиосигнала или представления опорного аудиосигнала посредством гребенки фильтров.

Согласно одному варианту осуществления, каждый из модулей оценки принимает в качестве ввода одну или более частей представления сформированного аудиосигнала или представления опорного аудиосигнала.

Согласно одному варианту осуществления, части сигнала формируются посредством дискретизации случайного окна (окон) кодирования со взвешиванием из входного сигнала, с использованием случайной оконной функции (функций).

Согласно одному варианту осуществления, дискретизация случайного окна кодирования со взвешиванием повторяется многократно для каждого модуля оценки.

Согласно одному варианту осуществления, число раз, когда случайное окно (окна) кодирования со взвешиванием дискретизируется для каждого модуля оценки, является пропорциональным длине представления сформированного аудиосигнала или представления опорного аудиосигнала.

Дополнительные варианты осуществления относятся к компьютерному программному продукту, включающему в себя программу для обрабатывающего устройства, содержащую элементы программного кода для выполнения этапов способов, описанных в данном документе, когда программа выполняется на обрабатывающем устройстве.

Согласно одному варианту осуществления, компьютерный программный продукт содержит машиночитаемый носитель, на котором сохраняются элементы программного кода, при этом программа является непосредственно загружаемой во внутреннее запоминающее устройство обрабатывающего устройства.

Дополнительные варианты осуществления относятся к способу формирования аудиосигнала, содержащего математическую модель, при этом математическая модель выполнена с возможностью вывода аудиовыборок с определенным временным шагом из входной последовательности (например, извлеченной из текста), представляющей аудиоданные, которые должны формироваться, при этом математическая модель выполнена с возможностью формирования шумового вектора для создания выходных аудиовыборок с использованием входной репрезентативной последовательности.

Согласно одному варианту осуществления математическая модель обучается с использованием аудиоданных. Согласно одному варианту осуществления, математическая модель представляет собой нейронную сеть. Согласно одному варианту осуществления, сеть представляет собой сеть с прямой связью. Согласно одному варианту осуществления, сеть представляет собой сверточную сеть.

Согласно одному варианту осуществления, шумовой вектор может иметь более низкую степень размерности, чем аудиосигнал, который должен формироваться. Первые данные могут иметь первую размерность или по меньшей мере на одну размерность ниже, чем аудиосигнал. Первые данные могут иметь общее число выборок по всем размерностям ниже, чем аудиосигнал. Первые данные могут иметь на одну размерность ниже, чем аудиосигнал, но число каналов, большее, чем аудиосигнал.

Согласно одному варианту осуществления, технология временной адаптивной денормализации (TADE) используется для обуславливания математической модели с использованием входной репрезентативной последовательности и в силу этого для формирования шумового вектора.

Согласно одному варианту осуществления, модифицированная стробированная TanH мягкого максимума активирует каждый слой нейронной сети.

Согласно одному варианту осуществления, операции свертки выполняются с максимальным коэффициентом растяжения в 2.

Согласно одному варианту осуществления, шумовой вектор, а также входная репрезентативная последовательность дискретизируются с повышением для получения выходных аудиоданных с целевой частотой дискретизации.

Согласно одному варианту осуществления, повышающая дискретизация выполняется последовательно в различных слоях математической модели.

Согласно одному варианту осуществления, коэффициент повышающей дискретизации для каждого слоя равен 2 или кратному 2, например, степени 2. В некоторых примерах, значения коэффициента повышающей дискретизации могут, если обобщать, быть больше 2.

Сформированный аудиосигнал может в общем случае использоваться при применении преобразования текста в речь, при этом входная репрезентативная последовательность извлекается из текста.

Согласно одному варианту осуществления, сформированный аудиосигнал используется в аудиодекодере, при этом входная репрезентативная последовательность представляет собой сжатое представление исходных аудиоданных, которые следует передать или сохранить.

Согласно одному варианту осуществления, сформированный аудиосигнал используется для повышения качества звучания ухудшенного аудиосигнала, при этом входная репрезентативная последовательность извлекается из ухудшенного сигнала.

Дополнительные варианты осуществления относятся к способу обучения нейронной сети для формирования аудиоданных, при этом нейронная сеть выводит аудиовыборки с определенным временным шагом из входной последовательности, представляющей аудиоданные, которые должны формироваться, при этом нейронная сеть выполнена с возможностью формирования шумового вектора для создания выходных аудиовыборок с использованием входной репрезентативной последовательности, при этом нейронная сеть конфигурирована, как изложено выше, и при этом обучение конфигурировано с возможностью оптимизации функции потерь.

Согласно одному варианту осуществления, функция потерь содержит фиксированный показатель, вычисленный между сформированным аудиосигналом и опорным аудиосигналом.

Согласно одному варианту осуществления, фиксированный показатель представляет собой одно или более спектральных искажений, вычисленных между сформированным аудиосигналом и опорным сигналом.

Согласно одному варианту осуществления, одно или несколько спектральных искажений вычисляются для абсолютной величины или логарифмической абсолютной величины спектрального представления сформированного аудиосигнала и опорного сигнала.

Согласно одному варианту осуществления, одно или несколько спектральных искажений, формирующих фиксированный показатель, вычисляются для различных временных или частотных разрешений.

Согласно одному варианту осуществления, функция потерь содержит состязательный показатель, извлекаемый посредством дополнительных дискриминативных нейронных сетей, при этом дискриминативные нейронные сети принимают в качестве ввода представление сформированных или опорных аудиосигналов, и при этом дискриминативные нейронные сети выполнены с возможностью оценки того, насколько реалистичными являются сформированные аудиовыборки.

Согласно одному варианту осуществления, функция потерь содержит как фиксированный показатель, так и состязательный показатель, извлекаемые посредством дополнительных дискриминативных нейронных сетей.

Согласно одному варианту осуществления, нейронная сеть, формирующая аудиовыборки, сначала обучается с использованием только фиксированного показателя.

Согласно одному варианту осуществления, состязательный показатель извлекается посредством 4 дискриминативных нейронных сетей.

Согласно одному варианту осуществления, дискриминативные нейронные сети работают после разложения входного аудиосигнала посредством гребенки фильтров.

Согласно одному варианту осуществления, каждая дискриминативная нейронная сеть принимает в качестве ввода одну или несколько случайных кодированных со взвешиванием версий входного аудиосигнала.

Согласно одному варианту осуществления, дискретизация случайного окна кодирования со взвешиванием повторяется многократно для каждой дискриминативной нейронной сети.

Согласно одному варианту осуществления, число раз, когда случайное окно кодирования со взвешиванием дискретизируется для каждой дискриминативной нейронной сети, является пропорциональным длине входных аудиовыборок.

Осуществление изобретения

На Фиг. 8 показан пример генератора 10 аудиоданных. Генератор 10 аудиоданных может преобразовывать текст 112 в выходной аудиосигнал 16. Текст 112 может преобразовываться в целевые данные 12 (см. ниже), которые в некоторых примерах можно понимать как аудиопредставление (например, спектрограмма или, обобщенно, спектрограммы, MFCC, такие как логарифмическая спектрограмма или спектрограмма или MFCC, или мел-спектрограмма, или другие акустические признаки). Целевые данные 12 могут использоваться для обуславливания входного сигнала 14 (например, шума) таким образом, чтобы обрабатывать входной сигнал 14 таким образом, что он становится слышимой речью. Блок 1110 аудиосинтеза (блок анализа текста) может преобразовывать текст 112 в аудиопредставление (например, в спектрограмму или, обобщенно, в спектрограммы, MFCC, такие как логарифмическая спектрограмма или спектрограмма или MFCC, или мел-спектрограмма, или другие акустические признаки), например, при условиях, определяемых целевыми данными 12. Блок 1110 аудиосинтеза, например, может отвечать за обработку по меньшей мере одного из дикции, фазирования, интонации, длительности и т.д. речи. Блок 1110 аудиосинтеза (блок анализа текста) может выполнять по меньшей мере одну задачу, такую как нормализация текста, сегментация на слова, прогнозирование просодий и преобразование графенов в фонемы. Затем, сформированные целевые данные 12 могут вводиться в блок 1120 синтеза форм сигналов (например, вокодер), который может формировать форму 16 сигнала (выходной аудиосигнал), например, из входного сигнала 14 на основе условий, полученных из целевых данных 12, полученных из текста 112.

Тем не менее, следует отметить, что блок 1110 в некоторых примерах не представляет собой часть генератора 10, но блок 1110 может быть внешним для генератора 10. В некоторых примерах, блок 1110 может подразделяться на множество субблоков (и в некоторых конкретных случаях по меньшей мере один из субблоков может представлять собой часть генератора 10, и по меньшей мере один из субблоков может быть внешним для генератора 10).

В общих чертах, ввод, который может представлять собой текст (или другой ввод, извлекаемый из текста), который вводится в блок 1110 (или генератор 10 в некоторых примерах), может иметь форму по меньшей мере одного из:

- текста 112 (например, код ASCII),

- по меньшей мере одного лингвистического признака (например, по меньшей мере одного из фонемы, просодии слов, интонации, разрывов фраз и заполненных пауз, например, полученных из текста),

- по меньшей мере одного акустического признака (например, по меньшей мере одного из логарифмической спектрограммы, MFCC и мел-спектрограммы, например, полученной из текста).

Ввод может обрабатываться (например, блоком 1110) для получения целевых данных 12. Согласно другим примерам, блок 1110 может выполнять обработку таким образом, чтобы получить целевые данные 12 (извлекаемые из текста) в форме по меньшей мере одного из:

- по меньшей мере одного из символа текста или слова,

- по меньшей мере одного лингвистического признака (например, по меньшей мере одного из фонемы, просодии слов, интонации, разрывов фраз и заполненных пауз, например, полученных из текста),

- по меньшей мере одного акустического признака (например, по меньшей мере одного из логарифмической спектрограммы, MFCC и мел-спектрограммы, например, полученной из текста).

Целевые данные 12 (в форме ли символа, лингвистических признаков или акустического признака) используются посредством генератора 10 (например, посредством блока синтеза форм сигналов, вокодера, 1120) для обуславливания обработки для входного сигнала 14, таким образом формируя выходной аудиосигнал (акустическую волну).

На Фиг. 10 показана синоптическая таблица для нескольких возможностей для создания экземпляра блока 1110:

A) В случае А ввод, введенный в блок 1110, представляет собой простой текст 112, и вывод (целевые данные 12) из блока 1110 представляет собой по меньшей мере одно из символа текста или слова (которое также представляет собой текст). В случае А блок 1110 выполняет выбор текста 112 для элементов текста 112. Затем целевые данные 12 (в форме элементов текста 112) должны обуславливать обработку для входного сигнала 14 таким образом, чтобы получить выходной сигнал 16 (акустическую волну).

B) В случае В ввод, введенный в блок 1110, представляет собой простой текст 112, и вывод (целевые данные 12) из блока 1110 содержат по меньшей мере один лингвистический признак, например, например, лингвистический признак из фонемы, просодии слов, интонации, разрыва фразы и заполненных пауз, полученных из текста 112 и т.д. В случае В блок 1110 выполняет лингвистический анализ для элементов текста 112, таким образом получая по меньшей мере один лингвистический признак по меньшей мере из одного из фонемы, просодии слов, интонации, разрыва фразы и заполненных пауз и т.д. Затем целевые данные 12 (в форме по меньшей мере одного из фонемы, просодии слов, интонации, разрыва фразы и заполненных пауз и т.д.) должны обуславливать обработку для входного сигнала 14 таким образом, чтобы получить выходной сигнал 16 (акустическую волну).

C) В случае С ввод, введенный в блок 1110, представляет собой простой текст 112, и вывод (целевые данные 12) из блока 1110 содержат по меньшей мере один акустический признак, например, один акустический признак из логарифмической спектрограммы или MFCC и мел-спектрограммы, полученной из текста. В случае С блок 1110 выполняет акустический анализ для элементов текста 112, за счет этого получая по меньшей мере один акустический признак из логарифмической спектрограммы или MFCC и мел-спектрограммы, полученной из текста 112. Затем целевые данные 12 (например, в форме по меньшей мере одного из акустических признаков из логарифмической спектрограммы, MFCC, мел-спектрограммы, полученной из текста, и т.д.) должны обуславливать обработку для входного сигнала 14 таким образом, чтобы получить выходной сигнал 16 (акустическую волну).

D) В случае D ввод, введенный в блок 1110, представляет собой лингвистический признак (например по меньшей мере одно из фонемы, просодии слов, интонации, разрыва фразы и заполненной паузы), и вывод также представляет собой обработанный лингвистический признак (например по меньшей мере одно из фонемы, просодии слов, интонации, разрыва фразы и заполненной паузы). Затем целевые данные 12 (в форме по меньшей мере одного из фонемы, просодии слов, интонации, разрыва фразы и заполненных пауз и т.д.) должны обуславливать обработку для входного сигнала 14 таким образом, чтобы получить выходной сигнал 16 (акустическую волну).

E) В случае Е ввод, введенный в блок 1110, представляет собой лингвистический признак (например по меньшей мере одно из фонемы, просодии слов, интонации, разрыв фразы и заполненная пауза), и вывод (целевые данные 12) из блока 1110 содержит по меньшей мере один акустический признак, например, один акустический признак из логарифмической спектрограммы или MFCC и мел-спектрограммы, полученной из текста. В случае Е блок 1110 выполняет акустический анализ для элементов текста 112, чтобы получать по меньшей мере один акустический признак из логарифмической спектрограммы или MFCC и мел-спектрограммы. Затем целевые данные 12 (например, в форме по меньшей мере одного из акустических признаков из логарифмической спектрограммы, MFCC, мел-спектрограммы, полученной из текста, и т.д.) должны обуславливать обработку для входного сигнала 14 таким образом, чтобы получить выходной сигнал 16 (акустическую волну).

F) В случае F ввод, введенный в блок 1110, имеет форму акустического признака (например, форму по меньшей мере одного из акустических признаков из логарифмической спектрограммы, MFCC, мел-спектрограммы, полученной из текста, и т.д.), и вывод (целевые данные 12) имеет форму обработанного акустического признака (например, форму по меньшей мере одного из акустических признаков из логарифмической спектрограммы, MFCC, мел-спектрограммы, полученной из текста, и т.д.). Затем целевые данные 12 (например, в форме обработанных акустических признаков, таких как по меньшей мере один из акустических признаков из логарифмической спектрограммы, MFCC, мел-спектрограммы, полученной из текста, и т.д.) должны обуславливать обработку для входного сигнала 14 таким образом, чтобы получить выходной сигнал 16 (акустическую волну).

На Фиг. 9а показан пример, в котором блок 1110 включает в себя субблок 1112 (блок анализа текста), который обеспечивает промежуточные целевые данные 212, и, ниже него, субблок 1114 (аудиосинтез, например, с использованием акустической модели), который формирует целевые данные 12 в форме акустических признаков. Следовательно, на фиг. 9а, если оба субблока 1112 и 1114 представляют собой часть генератора 10, происходит случай С. Если субблок 1112 не представляет собой часть генератора 10, но субблок 1114 представляет собой часть генератора 10, происходит случай Е.

На Фиг. 9b показан пример, в котором блок 1110 выполняет только анализ текста и обеспечивает целевые данные 12 в форме лингвистических признаков. Следовательно, на фиг. 9b, если блок 1110 представляет собой часть генератора 10, происходит случай В.

На Фиг. 9с показан пример, в котором блок 1110 отсутствует, а целевые данные 112 имеют форму лингвистических признаков.

В общем случае, блок 1110 (если он присутствует) работает с возможностью все более и более подробного анализа текста (или другого ввода, полученного из текста), при обработке к целевым данным, которые анализируются более подробно, чем ввод, введенный в блок 1110. Блок 1110 также может использовать ограничения (например, функцию внимания, голос мужчины/женщины, акцент, эмоциональную характеризацию и т.д.), которые могут отсутствовать в исходном тексте. В общем случае эти ограничения могут быть установлены пользователем.

Следует отметить, что в вышеприведенных и нижеприведенных случаях блок 1110 (либо, если они присутствуют, любой из его субблоков, например любой из блоков 1112 и 1114) может использовать статистическую модель, например, выполняющую анализ текста и/или использующую акустическую модель. Помимо этого или в качестве альтернативы, блок 1110 (либо, если они присутствуют, любой из его субблоков, например любой из блоков 1112 и 1114) может использовать обучаемую модель, например, выполняющую анализ текста и/или использующую акустическую модель. Обучаемая модель может быть основана, например, на нейронных сетях, марковских цепях и т.д. Опять же кроме этого или в качестве дополнительной альтернативы, блок 1110 (либо, если они присутствуют, любой из его субблоков, например любой из блоков 1112 и 1114) может использовать алгоритм на основе правил, выполняющий анализ текста и/или основанный на акустической модели.

В некоторых примерах блок 1110 (либо, если они присутствуют, любой из его субблоков, например любой из блоков 1112 и 1114) может извлекать целевые данные детерминированным образом. Следовательно, имеется вероятность того, что некоторый субблок(и) является обучаемым, а другие субблоки являются детерминированными.

Блок 1110 также называется «блоком анализа текста» (например, при преобразовании текста по меньшей мере в один лингвистический признак) или «блоком аудиосинтеза» (например, при преобразовании текста или по меньшей мере одного лингвистического признака по меньшей мере в один акустический признак, такой как спектрограмма). В любом случае, установлено, что целевые данные 12 могут иметь форму текста, лингвистического признака или акустического признака согласно вариантам осуществления.

В частности, на фиг. 10 показано, что некоторые сочетания преобразований в общем не предусмотрены. Это обусловлено тем, что преобразования из подробно анализируемого признака в простой признак (например, из лингвистического признака в текст либо из акустического признака в текст или в лингвистический признак) не предполагаются.

На Фиг. 6 показан пример генератора 10 аудиоданных, который может формировать (например, синтезировать) аудиосигнал 16 (выходной сигнал), например, согласно StyleMelGAN. На фиг. 6 текст 112 может обрабатываться, например, посредством блока 1110 анализа текста для получения целевых данных 12. Затем в блоке 1120 синтеза форм сигналов могут использоваться целевые данные 12 для обработки входного сигнала 14 (например, шума) для получения слышимого аудиосигнала 16 (формы акустического сигнала). Полученные целевые данные 12 могут извлекаться из текста.

В частности, выходной аудиосигнал 16 может формироваться на основе входного сигнала 14 (также называемого «скрытым сигналом», который может представлять собой шум, например, белый шум) и целевых данных 12 (также называемых «входной последовательностью» и в некоторых примерах извлекаемых из текста), и которые могут быть получены, например, из текста 112 в блоке 1110. Целевые данные 12, например, могут содержать (например, представлять собой) спектрограмму (например, мел-спектрограмму), причем мел-спектрограмма обеспечивает преобразование, например, последовательности временных выборок в мел-шкалу. Помимо этого или в качестве альтернативы, целевые данные 12 могут содержать (например, представлять собой) поток битов. Например, целевые данные могут представлять собой или включать в себя текст (или в более общем случае могут быть извлечены из текста), который должен воспроизводиться в аудиоданных (например, преобразование текста в речь). В общем случае целевые данные 12 должны обрабатываться для получения речевого звука, распознаваемого слушателем-человеком как естественный звук. Входной сигнал 14 может представлять собой шум (который как таковой не переносит полезную информацию), например, белый шум, но, в генераторе 10, шумовой вектор, извлеченный из шума, стилизуется (например, в позиции 77) таким образом, что он имеет шумовой вектор с акустическими признаками, обусловленными посредством целевых данных 12. В конечном итоге выходной аудиосигнал 16 должен пониматься слушателем-человеком как речь. Шумовой вектор 14 может представлять собой, аналогично фиг. 1, вектор 128×1 (одну отдельную выборку, например, выборки временной области или выборки частотной области и 128 каналов). В других примерах может использоваться другая длина шумового вектора 14.

Первый блок 50 обработки показан на фиг. 6. Как показано (например, на фиг. 1), первый блок 50 обработки может подвергаться созданию экземпляра посредством каждого из множества блоков (на фиг. 1, посредством блоков 50а, 50b, 50с, 50d, 50е, 50f, 50g, 50h). Блоки 50a-50h могут пониматься как формирующие один отдельный блок 40. Показано, что в первом блоке 40, 50 обработки, обуславливающий набор обучаемых слоев (например, 71, 72, 73) может использоваться для обработки целевых данных 12 и/или входного сигнала 14. Соответственно, параметры 74, 75 обуславливающих признаков (также называемые «гамма, у» и «бета, [3», на фиг. 3) могут быть получены, например, посредством свертки во время обучения. Обучаемые слои 71-73 могут в силу этого представлять собой часть слоя весовых коэффициентов обучающей сети или, если обобщать, другой обучающей структуры. Первый блок 40, 50 обработки может включать в себя по меньшей мере один стилизующий элемент 77. По меньшей мере, один стилизующий элемент 77 может выводить первые выходные данные 69. По меньшей мере, один стилизующий элемент 77 может применять параметры 74, 75 обуславливающих признаков к входному сигналу 14 (скрытому) либо к первым данным 15, полученным из входного сигнала 14.

Первые выходные данные 69 в каждом блоке 50 находятся во множестве каналов. Генератор 10 аудиоданных может включать в себя второй блок 45 обработки (на фиг. 1 показан как включающий в себя блоки 42, 44, 46). Второй блок 45 обработки может быть выполнен с возможностью комбинирования множества каналов 47 первых выходных данных 69 (введенных в качестве вторых входных данных или вторых данных) таким образом, чтобы получить выходной аудиосигнал 16 в одном отдельном канале, но в последовательности выборок.

«Каналы» следует понимать не в контексте стереозвука, а в контексте нейронных сетей (например, сверточных нейронных сетей). Например, входной сигнал 14 (например, скрытый шум) может находиться в 128 каналах (в представлении во временной области), поскольку предусмотрена последовательность каналов. Например, когда сигнал имеет 176 выборок и 64 канала, он может пониматься в качестве матрицы из 176 столбцов и 64 строк, тогда как, когда сигнал имеет 352 выборки и 64 канала, он может пониматься в качестве матрицы из 352 столбцов и 64 строк (другие схематизации являются возможными). Следовательно, сформированный аудиосигнал 16 (который на фиг. 1 приводит к матрице-строке 1×22528, где 22528 может быть заменено любым другим числом) может пониматься как моносигнал. В случае если стереосигналы должны формироваться, то раскрытая технология должна просто повторяться для каждого стереоканала, с тем чтобы получать несколько аудиосигналов 16, которые впоследствии микшируются.

По меньшей мере исходный входной сигнал 14 и/или сформированная речь 16 могут представлять собой вектор. Наоборот, вывод каждого из блоков 30 и 50a-50h, 42, 44 имеет, в общем, различную степень размерности. Первые данные могут иметь первую размерность или по меньшей мере на одну размерность ниже размерности аудиосигнала. Первые данные могут иметь общее число выборок по всем размерностям ниже, чем аудиосигнал. Первые данные могут иметь на одну размерность ниже, чем аудиосигнал, но число каналов, большее, чем аудиосигнал. В каждом блоке 30 и 50a-50h, сигнал, меняющийся от шума 14 до речи 16, может подвергаться повышающей дискретизации. Например, в блоке 30 повышающей дискретизации перед первым блоком 50а из блоков 50а-50h, выполняется 88-кратная повышающая дискретизация. Пример повышающей дискретизации может включать в себя, например, следующую последовательность: 1) повторение одинакового значения, 2) вставка нулей, 3) еще одно повторение или вставка нулей + линейная фильтрация и т.д.

Сформированный аудиосигнал 16, в общем, может представлять собой одноканальный сигнал (например, 1×22528). В случае если требуются несколько аудиоканалов (например, для воспроизведения стереозвука), то заявленная процедура, в принципе, должна итеративно выполняться многократно.

Аналогичным образом, также целевые данные 12, в принципе, могут находиться в одном отдельном канале (например, если они представляют собой текст или в более общем случае если они извлечены из текста, как в случае А, или как на Фиг. 9с) или во множестве каналов (например, в спектрограммах, например в мел-спектрограммах, например извлеченных из текста, например как в случаях С, Е, F). В любом случае, они могут быть дискретизированы с повышением (например, на коэффициент два, степень 2, число, кратное 2 или значение больше 2) для адаптации к размерностям сигнала (59а, 15, 69), эволюционирующего вдоль последующих слоев (50a-50h, 42), например, таким образом, чтобы получить параметры 74, 75 обуславливающих признаков с размерностями, адаптированными к размерностям сигнала.

Когда для первого блока 50 обработки создаются экземпляры, например, по меньшей мере во множестве блоков 50a-50h, число каналов, например, может оставаться одинаковым для множества блоков 50a-50h. Первые данные могут иметь первую размерность или по меньшей мере на одну размерность ниже размерности аудиосигнала. Первые данные могут иметь общее число выборок по всем размерностям ниже, чем аудиосигнал. Первые данные могут иметь на одну размерность ниже, чем аудиосигнал, но число каналов, большее, чем аудиосигнал.

Сигнал в последующих блоках может иметь различные размерности относительно друг друга. Например, выборка может дискретизироваться с повышением все большее число раз для достижения, например, от 88 выборок до 22528 выборок в последнем блоке 50h. Аналогичным образом, также целевые данные 12 дискретизируются с повышением в каждом блоке 50 обработки. Соответственно, параметры 74, 75 обуславливающих признаков могут адаптироваться к числу выборок сигнала, который должен обрабатываться. Соответственно, семантическая информация, обеспечиваемая целевыми данными 12, не теряется в последующих слоях 50a-50h.

Следует понимать, что примеры могут выполняться согласно парадигмам генеративно-состязательных сетей (GAN). GAN включает в себя генератор 11 GAN (фиг. 1) и дискриминатор 100 GAN (фиг. 2), который также можно понимать как часть блока 1120 синтеза форм сигналов. Генератор 11 GAN стремится сформировать аудиосигнал 16, который является максимально близким к реальному сигналу. Дискриминатор 100 GAN должен распознавать, является ли сформированный аудиосигнал реальным (таким как реальный аудиосигнал 104 на фиг. 2) или поддельным (таким как сформированный аудиосигнал 16). Как генератор 11 GAN, так и дискриминатор 100 GAN могут быть получены в виде нейронных сетей. Генератор 11 GAN должен минимизировать потери (например, через способ градиентов или другие способы) и обновлять параметры 74, 75 обуславливающих признаков путем учета результатов в дискриминаторе 100 GAN. Дискриминатор 100 GAN должен уменьшать собственные дискриминационные потери (например, через способ градиентов или другие способы) и обновлять собственные внутренние параметры. Соответственно, генератор GAN 11 обучается для обеспечения всех лучших аудиосигналов 16, тогда как дискриминатор 100 GAN обучается для распознавания реальных сигналов 16 из поддельных аудиосигналов, сформированных генератором 11 GAN. В общих чертах, очевидно, что генератор 11 GAN может включать в себя функциональности генератора 10 по меньшей мере без функциональностей дискриминатора 100 GAN. Следовательно, в большей части вышеуказанного, очевидно, что генератор 11 GAN и генератор 10 аудиоданных могут иметь в той или иной степени одинаковые признаки, отличные от признаков дискриминатора 100. Генератор 10 аудиоданных может включать в себя дискриминатор 100 в качестве внутреннего компонента. Следовательно, генератор 11 GAN и -дискриминатор 100 GAN могут вместе составлять генератор 10 аудиоданных. В примерах, в которых дискриминатор 100 GAN отсутствует, генератор 10 аудиоданных может состоять только из -генератора 11 GAN.

Как поясняет формулировка «обуславливающий набор обучаемых слоев», генератор 10 аудиоданных может быть получен в соответствии с парадигмами условных GAN, например, на основании условной информации. Например, условная информация может состоять из целевых данных 12 (либо их дискретизированной с повышением версии), на которых обучается обуславливающий набор слоев 71-73 (слой весовых коэффициентов), и получаются параметры 74, 75 обуславливающих признаков. Следовательно, стилизующий элемент 77 обуславливается посредством обучаемых слоев 71-73.

Примеры могут быть основаны на сверточных нейронных сетях. Например, небольшая матрица (например, фильтр или ядро), которая может представлять собой матрицу 3×3 (или матрицу 4×4 и т.д.), сворачивается (свертывается) вдоль большей матрицы (например, канал х дискретизирует скрытый или входной сигнал и/или спектрограмму, и/или спектрограмму или дискретизированную с повышением спектрограмму либо, в общем случае, целевые данные 12), например, что подразумевает комбинирование (например, умножение и сумму произведений; произведение с точкой и т.д.) между элементами фильтра (ядра) и элементами большей матрицы (активационной картой или активационной сигнала). Во время обучения, получаются (обучаются) элементы фильтра (ядра), которые представляют собой элементы, которые минимизируют потери. Во время логического вывода, используются элементы фильтра (ядра), которые получены во время обучения. Примеры сверток приводятся в блоках 71-73, 61а, 61b, 62а, 62b (см. ниже). Если блок является условным (например, блок 60 по фиг. 3), то свертка не обязательно применяется к сигналу, эволюционирующему из входного сигнала 14, к аудиосигналу 16 через промежуточные сигналы 59а (15), 69 и т.д., но может применяться к целевому сигналу 14. В других случаях (например, в блоках 61а, 61b, 62а, 62b), свертка может быть не условной и, например, может непосредственно применяться к сигналу 59а (15), 69 и т.д., эволюционирующему из входного сигнала 14, к аудиосигналу 16. Как видно из фиг. 3 и 4, могут выполняться условные и безусловные свертки.

Можно иметь, в некоторых примерах, активирующие функции ниже свертки (ReLu, TanH, функцию мягкого максимума и т.д.), которые могут отличаться в соответствии с намеченным эффектом. ReLu может преобразовывать максимум между 0 и значением, полученным в свертке (на практике она сохраняет одинаковое значение, если оно является положительным, и выводит 0 в случае отрицательного значения). Текучая ReLu может выводить х, если х>0, и 0,1*х, если х≤0, причем х является значением, полученным посредством свертки (вместо 0,1, другое значение, например, заданное значение в 0,1±0,05, может использоваться в некоторых примерах). TanH (которая может быть реализована, например, в блоке 63а и/или 63b) может обеспечивать гиперболический тангенс значения, полученного в свертке, например:

причем х является значением, полученным в свертке (например, в блоке 61а и/или 61b). Функция мягкого максимума (например, применяемая, например, в блоке 64а и/или 64b) может применять экспоненциал к каждому элементу из элементов результата свертки (например, полученному в блоке 62а и/или 62b) и нормализовать его посредством деления на сумму экспоненциалов. Функция мягкого максимума (например, в 64а и/или 64b) может обеспечивать распределение вероятностей для записей, которые находятся в матрице, которая получается в результате свертки (например, как предусмотрено в 62а и/или 62b). После применения активирующей функции, этап объединения в пул может выполняться (не показан на чертежах) в некоторых примерах, но в других примерах он может исключаться.

На Фиг. 4 показано, что также можно иметь стробированную функцию TanH мягкого максимума, например, посредством умножения (например, в 65а и/или 65b) результата функции TanH (например, полученного в 63а и/или 63b) на результат функции мягкого максимума (например, полученный в 64а и/или 64b).

Несколько слоев сверток (например, обуславливающий набор обучаемых слоев) могут располагаться друг за другом и/или параллельно друг другу, с тем чтобы увеличивать эффективность. Если предусмотрено применение активирующей функции и/или объединения в пул, они также могут повторяться в различных слоях (либо, например, могут быть предусмотрены различные активирующие функции, которые могут применяться к различным слоям).

Входной сигнал 14 (например, шум) обрабатывается, на различных этапах, так что он становится сформированным аудиосигналом 16 (например, при условиях, заданных посредством обуславливающих наборов обучаемых слоев 71-73, и для параметров 74, 75, обученных посредством обуславливающих наборов обучаемых слоев 71-73). Следовательно, входной сигнал должен пониматься как эволюционирующий в направлении обработки (от 14 к 16 на фиг. 6) в сторону становления сформированным аудиосигналом 16 (например, речью). Условия фактически формируются на основе целевого сигнала 12 и на основе обучения (с тем чтобы достигать самого предпочтительного набора параметров 74, 75).

Также следует отметить, что может считаться, что множество каналов входного сигнала (либо любой из его эволюций) имеют набор обучаемых слоев и стилизующий элемент, ассоциированный с ними. Например, каждая строка матриц 74 и 75 ассоциирована с конкретным каналом входного сигнала (либо одной из его эволюций) и в силу этого получается из конкретного обучаемого слоя, ассоциированного с конкретным каналом. Аналогичным образом, можно считать, что стилизующий элемент 77 формируется посредством множества стилизующих элементов (каждый из которых предназначен для каждой строки входного сигнала х, с, 12, 76, 76', 59, 59а, 59b и т.д.).

На Фиг. 1 показан пример генератора 10 аудиоданных (который может осуществлять генератор 10 аудиоданных по фиг. 6), который также может содержать (например, представлять собой) генератор 11 GAN. Следует отметить, что на Фиг. 1 показаны только элементы блока 1120 синтеза форм сигналов, поскольку целевые данные 12 уже преобразованы из текста 112. Целевые данные 12, например, полученные из текста, указываются в виде мел-спектрограммы, входной сигнал 14 может представлять собой скрытый шум, и вывод сигнала 16 может представлять собой речь (тем не мене, другие примеры являются возможными, как пояснено выше). Как можно видеть, входной сигнал 14 имеет только одну выборку и 128 каналов (могут быть определены другие числа). Шумовой вектор 14 может получаться в векторе с 128 каналами (но другие числа являются возможными) и может иметь нормальное распределение нулевого среднего. Шумовой вектор может соответствовать формуле:

Шумовой вектор может представлять собой случайный шум размерности 128 со сформированным средним значением 0 и с автокорреляционной матрицей (квадратом 128×128), равной единичному элементу I (можно осуществлять другой выбор). Следовательно, в примерах, сформированный шум может полностью декоррелироваться между каналами и иметь дисперсию 1 (энергию). N(0,I128) может сформирован в каждых 22528 сформированных выборок (либо для других примеров могут быть выбраны другие числа); размерность может в силу этого быть равна 1 на временной оси и 128 на канальной оси.

Показано, что шумовой вектор 14 пошагово обрабатывается (например, в блоках 50a-50h, 42, 44, 46 и т.д.) таким образом, чтоб он эволюционирует, например, из шума 14, например, в речь 16 (эволюционирующий сигнал должен указываться, например, с помощью различных сигналов 15, 59а, х, с, 76', 79, 79а, 59b, 79b, 69 и т.д.).

В блоке 30, входной сигнал 14 (шум) может дискретизироваться с повышением таким образом, что он имеет 88 выборок (возможны различные числа) и 64 канала (возможны различные числа).

Как можно видеть, восемь блоков 50а, 50b, 50с, 50d, 50е, 50f, 50g, 50h обработки (все из которых осуществляют первый блок 50 обработки по фиг. 6) могут увеличивать число выборок посредством выполнения повышающей дискретизации (например, максимум 2-кратной повышающей дискретизации). Число каналов может всегда оставаться одинаковым (например, 64) вдоль блоков 50а, 50b, 50с, 50d, 50е, 50f, 50g, 50h. Выборки, например, могут составлять число выборок в секунду (или другую единицу времени): можно получать, в выводе блока 50h, звук при более чем 22 кГц.

Каждый из блоков 50a-50h (50) также может представлять собой остаточный блок TADE (остаточный блок в контексте TADE, временной адаптивной денормализации). В частности, каждый блок 50a-50h может обусловливаться целевыми данными 12 (например, текстовым признаком, лингвистическим признаком или акустическим признаком, таким как мел-спектрограмма).

Во втором блоке 45 обработки (фиг. 1 и 6), может получаться только один отдельный канал, и несколько выборок получаются в одной отдельной размерности. Как можно видеть, используется другой остаточный блок 42 TADE (помимо блоков 50a-50h) (который уменьшается в один отдельный канал). Затем сверточный слой 44 и активирующая функция (которая, например, может представлять собой TanH 46) могут выполняться. После этого, речь 16 получается (и, возможно, сохраняется, подготавливается посредством рендеринга, кодируется и т.д.).

По меньшей мере один из блоков 50a-50h (или каждый из них, в конкретных примерах), например, может представлять собой остаточный блок. Остаточный блок управляет прогнозированием только для остаточного компонента сигнала, эволюционирующего из входного сигнала 14 (например, шума) в выходной аудиосигнал 16. Остаточный сигнал представляет собой только часть (остаточный компонент) основного сигнала. Например, несколько остаточных сигналов могут суммироваться между собой, с тем чтобы получать конечный выходной аудиосигнал 16.

На Фиг. 4 показан пример одного из блоков 50a-50h (50). Как можно видеть, в каждый блок 50 вводятся первые данные 59а, которые представляют собой либо входной сигнал 14 (или его дискретизированную с повышением версию, например, версию, выводимую посредством блока 30 повышающей дискретизации), либо вывод из предшествующего блока. Например, в блок 50b может вводиться вывод блока 50а; в блок 50с может вводиться вывод блока 50b и т.д.

На фиг. 4, в силу этого можно видеть, что обрабатываются первые данные 59а, переданные в блок 50 (50a-50h), и его вывод представляет собой выходной сигнал 69 (который должен передаваться в качестве ввода в следующий блок). Как указано посредством линии 59а', основной компонент первых данных 59а, введенных в первый блок 50a-50h (50) обработки, фактически обходит большую часть обработки первого блока 50a-50h (50) обработки. Например, блоки 60а, 61а, 62а, 63а, 65а, 60b, 61b, 62b, 63b, 64b and 65b обходятся посредством обходной линии 59а'. Первые данные 59а затем должны суммироваться с остаточной частью 64b' в сумматоре 65с (который указывается на фиг. 4, но не показан). Эта обходная линия 59а' и суммирование в сумматоре 65с могут пониматься как создающие экземпляр такого факта, что каждый блок 50 (50a-50h) обрабатывает операции с остаточными сигналами, которые затем суммируются с основной частью сигнала. Следовательно, каждый из блоков 50a-50h может считаться остаточным блоком.

В частности, суммирование в сумматоре 65с не обязательно должно выполняться в остаточном блоке 50 (50a-50h). Одно суммирование множества остаточных сигналов 65b' (каждый из которых выводится посредством каждого из остаточных блоков 50а-50h) может выполняться (например, в блоке суммирования, например, во втором блоке 45 обработки). Соответственно, различные остаточные блоки 50a-50h могут работать параллельно друг другу.

В примере по фиг. 4, каждый блок 50 может повторять свои сверточные слои дважды (например, сначала в реплике 600, включающей в себя по меньшей мере один из блоков 60а, 61а, 62а, 63а, 64а, 65а и получающей сигнал 59b; затем в реплике 601, включающей в себя по меньшей мере один из блоков 60b, 61b, 62b, 63b, 64b, 65b и получающей сигнал 65b', который может суммироваться с основным компонентом 59а').